Amazon Web Services ブログ

【開催報告】Neuron Community – Vol.2

こんにちは、ソリューションアーキテクトの宇佐美です。

2025年7月15日に開催された「Neuron Community – Vol.2」の様子をレポートします。

このイベントは、「Neuron Community」の協力のもと開催しました。

Neuron Community とは

AWS では、機械学習のトレーニングと推論のための高性能で費用対効果の高い機械学習アクセラレータ( AWS Trainium、AWS Inferentia )、および深層学習と生成 AI ワークロードを実行するために使用される SDK の AWS Neuron を提供しています。「Neuron Community」は、ユーザー間で AWS Trainium / AWS Inferentia / AWS Neuron の知見共有を促進する場として発足しました。

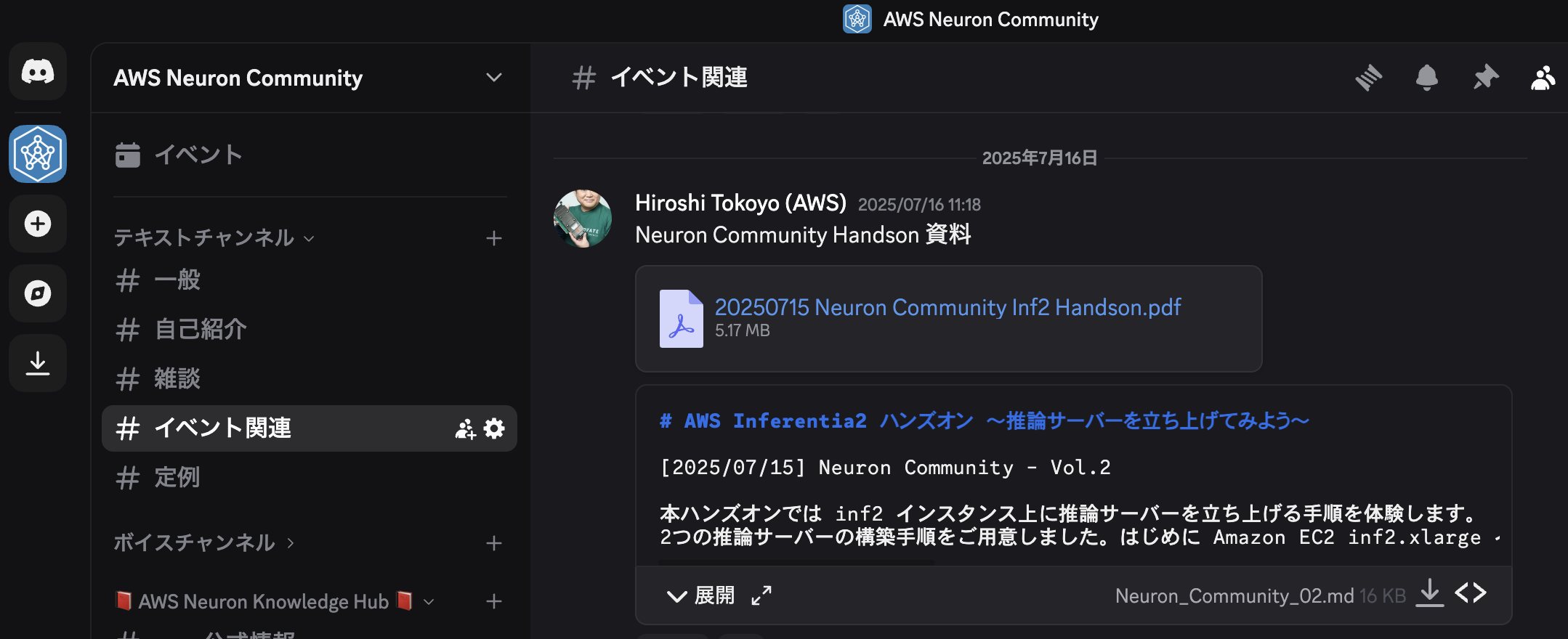

「Neuron Community」は、主に Discord を使用して運営されています。興味を持っていただいた方は、下記の URL から参加してみてください。

AWS Neuron Community (Discord) : https://discord.gg/DUx4g3Z3pq

オープニングセッション

常世 大史 (Amazon Web Services Japan G.K.)

資料:Discord 上の Neuron Community 内で公開しています。

オープニングでは、AWS 内で Trainium と Inferentia を開発している部門、Annapurna Labs 所属の常世より、Neuron Community の立ち上げ経緯と初回イベント「Neuron Community – Day One」の振り返り、さらに2025年6月25日・26日に開催された AWS Summit Japan 2025 を Trainium、Inferentia、Neuron の視点から振り返りました。AWS Summit Japanでは、AWS が独自開発を行っている Trainium、Inferentia 等のチップおよび搭載モジュールの実物展示や、Amazon EC2 Trn2 UltraServers の実物大パネル展示を実施したことを紹介しました。

また、Discord 上で立ち上がった Neuron Community についても改めて紹介しました。Neuron Community は2025年7月19日現在、56名が参加する規模へと成長しています。ユーザー同士が気軽に交流・議論できる場を目指して、コミュニティのさらなる発展を呼びかけました。

ライトニングトーク

清丸 寛一氏(国立情報学研究所)「日本語 LLM の対決の舞台「LLM-jp Chatbot Arena」を支える技術」

資料:Discord 上の Neuron Community 内で公開していただいています。

国立情報学研究所の清丸氏からは、「日本語 LLM の対決の舞台「LLM-jp Chatbot Arena」を支える技術」と題して、大規模言語モデル (LLM : Large Language Model) を利用したサービス「LLM-jp Chatbot Arena」でどのように AWS Trainium を利用しているかについて紹介していただきました。LLM-jp Chatbot Arena は、2つの日本語 LLM の応答を同時に比較し、優れた方に投票できるプラットフォームです。投票の結果は、LLM の改善のために役立てることができます。

LLM-jp Chatbot Arena では、モデルに応じてインスタンスを使い分けており、一番大きなサイズである LLM-jp-3 172B モデルでは、Amazon EC2 Trn1 インスタンス (trn1.32xlarge) を推論サーバーとして採用しているとのことです。Amazon EC2 インスタンスタイプは、運用コストを下げることを狙いとして選択されており、GPU ベースの p4d.24xlarge インスタンスと比較した場合、メモリサイズは約 80% になるものの、コストが 約 60% に抑えられる点を評価していただきました。

また、LLM-jp Chatbot Arena のアーキテクチャについても説明していただき、UI サーバーに Gradio、リクエストルーターに LiteLLM、 推論サーバーに vLLM を利用しているとのことでした。

Amazon EC2 Trn1 インスタンスを利用した感想は「想像以上にふつうに動く」とのことで、チャットボットとして十分な速度で、数ヶ月間止まることなく安定して動作したということです。一方、いくつかの注意点も共有していただき、「公式の最新ドキュメント」を参照することが重要というアドバイスをいただきました。

セッションの後の質疑応答も大いに盛り上がっていたのが印象的でした。

中山 裕貴氏、福嶋 慶介氏(ソフトバンク株式会社)「Inferentia Is All You Need (Even for Non-LLMs)」

ソフトバンク株式会社の中山氏、福嶋氏からは、「Inferentia Is All You Need (Even for Non-LLMs)」と題して、社内のシステムで活用されている従来の AIを活用した推論モデルを NVIDIA T4 GPU搭載 Amazon EC2 G4 インスタンス(g4dn)から推論向け AI アクセラレータである AWS Inferentia 搭載 Amazon EC2 Inf1 インスタンス へ移行された事例をご紹介いただきました。

お客様のシステムでは g4dn を利用していましたが、そのコストが課題となっていたため、コストパフォーマンスの高いInferentia の導入を検討されました。独自に開発されたモデルであったため、導入にあたっていくつかの課題に直面し、苦労は大きかったとのことです。中山氏、福嶋氏はエラーログを確認しつつ、一つ一つ解決していくことで Inferentia へのモデルの移行に成功し、推論速度が 1.3倍、コストを 44.2% 削減できたとお話しくださいました。 Neuron 未対応モデルを自社で対応するための努力と工夫はたいへん興味深く、参加者から多くの質問が出たことが印象的でした。最後に 「LLM だけでなく古典的なモデルでも Inferentia が活用できるInferentia is All We Need ? 」とセッションを結んでいただきました。

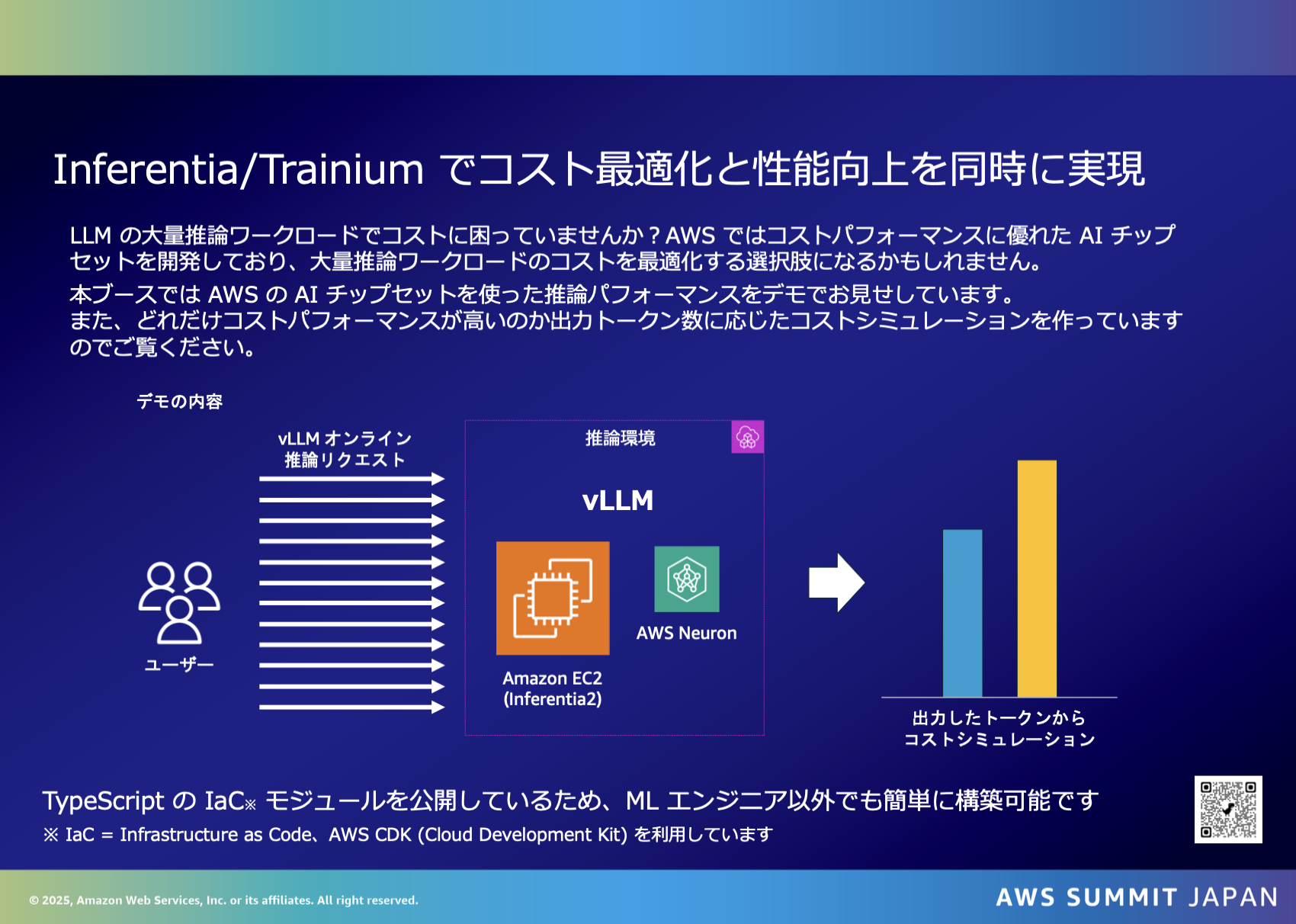

吉川 幸弘(Amazon Web Services Japan G.K.)「AWS Summit Japan 2025 デモ再演 ~Inferentia/Trainium で徳得を詰め!推論コスパシミュレーション~」

最後のセッションでは、SA の吉川から AWS Summit Japan 2025 の AWS Builders’ Fair Booth で展示していたデモを再演しました。デモの内容は vLLM に対して大量に推論リクエストを送信し、そのトークン対コストを可視化するというものです。

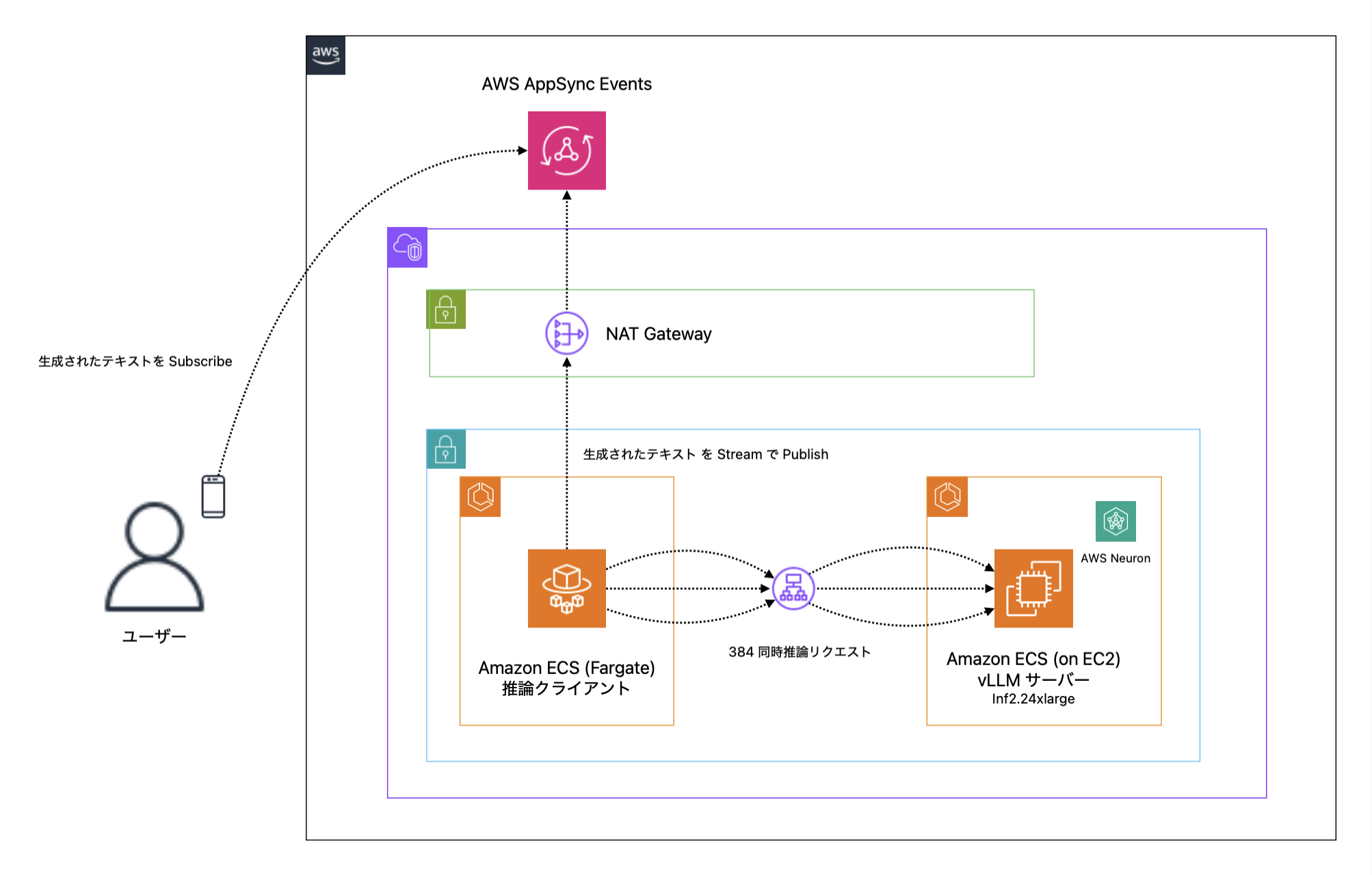

具体的には以下のようなアーキテクチャで、inf2.24xlarge の EC2 インスタンス 1 台に Llama 3 8B モデルをデプロイして 384 リクエストを同時に送り続け、レスポンスが完了したら次のリクエストを送り続けるインスタンス泣かせなデモアプリケーションです。

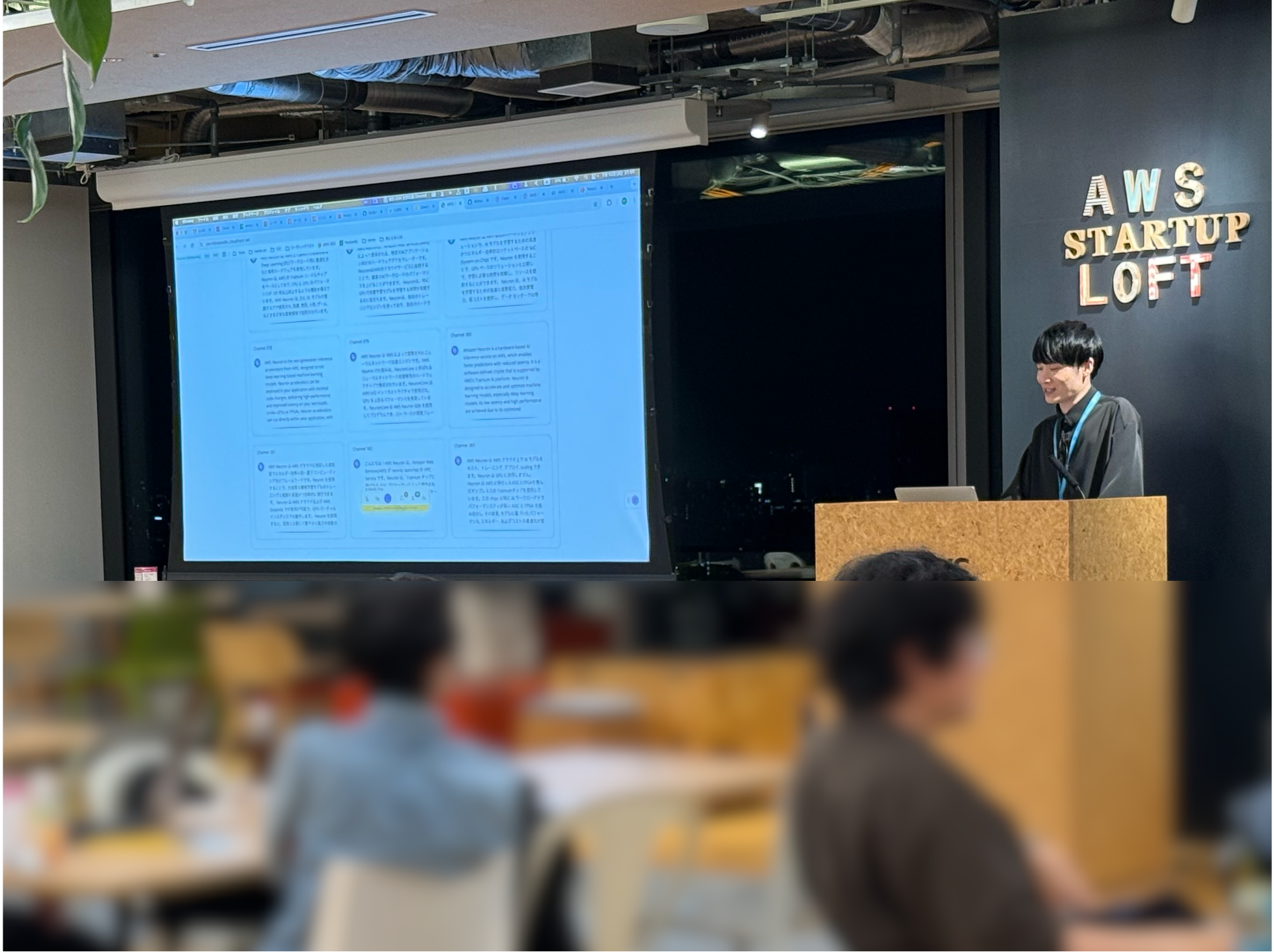

以下の写真は実際のデモの様子です。

写真内で投影されているブラウザ内の吹き出しは、それぞれがストリームレスポンスしている AWS Inferentia2 からのレスポンスです。この写真では 9 つの吹き出ししか見えていませんが、実際には 384 の吹き出しがあり、ブラウザのスクロールバーをスクロールすると同様の吹き出しが 384 個ズラっと並んでいます。ちなみに同時処理数を 384 としている背景は TP (tensor parallel size) を 8、 batch size を 128 に設定してモデルを動かす Amazon ECS タスク 3 つを内部に Neuron コアを 24 個持った inf2.48xlarge 1 台で動作させているため、128 batch size × 3 tasks で 384 同時処理にしています。batch size を 128 としていること自体もレイテンシーとスループットが個人的な主観で良さそうだと思ったパラメータがこの設定だっただけで、アクセラレータデバイスのメモリ上これが限界というわけではないというのも面白い部分です。

このデモでは、Neuronx patterns Construct Library という Inferentia2 / Trainium1 で LLM を簡単に動かすための AWS CDK Construct Library (AWS の Infrastructure as Code Module) を使用しています。このライブラリは、LLM の サーバーを Infrastructure as Code として管理したい方のために、吉川が個人の OSS として開発・公開しているもので、Application Load Balancer と Amazon ECS on EC2 部分の構築に利用しています。

AWS Inferentia2 ハンズオン 「〜推論サーバーを立ち上げてみよう〜」

資料:Discord 上の Neuron Community 内で公開しています。

イベント後半では、AWS Summit Japan 2025 のセッション「GPU 以外の選択肢!開発チームが徹底解説、効率的な AI 基盤の作り方」の内容を基に、AWS Inferentia2 の実践的なハンズオンを実施しました。参加者の皆様には、以下の2つの推論サーバー構築手順を体験していただきました:

- Amazon EC2 Inf2 インスタンス (inf2.xlarge) 上で vLLM を利用し、Llama 3.2 マルチモーダルモデルをデプロイ

- Amazon SageMaker AI 上で Hugging Face TGI コンテナを利用し、Qwen 2.5 モデルを簡単にデプロイ

ライトニングトークでの活発な質疑応答の結果、ハンズオンの時間が予定より短くなりましたが、Amazon EC2 Inf2 インスタンス上で推論サーバーを立ち上げる手順は理解していただけたかと思います。使用した日本語のハンズオンコンテンツは Neuron Community で公開していますので、本イベントに参加できなかった方も、ぜひご自身のペースでお試しください。セルフペースでのハンズオン実施中に困ったことがあれば、コミュニティメンバーに気軽に質問できるのも、ユーザーコミュニティならではの強みですね。

さいごに

第2回目の Neuron Community も、ユーザーの皆さまからたいへん興味深い発表をしていただき、大いに盛り上がりました。質疑応答が盛り上がりすぎて時間が足りなくなったのは、次回への反省点です。

この機会に、Discord の AWS Neuron Community に参加してくれた方も、たくさんいらっしゃったようです。第3回目の Neuron Community も、Discord を中心に募集や告知を行っていきます。興味を持っていただいた方は、ぜひ、下記の URL から参加してみてください。

AWS Neuron Community (Discord) : https://discord.gg/DUx4g3Z3pq