Amazon Web Services ブログ

Amazon Bedrock を使用した Well-Architected な生成 AI ソリューションによる運用上の優秀性の実現

本記事は、2024 年 10 月 2 日に AWS Machine Learning Blog で公開された Achieve operational excellence with well-architected generative AI solutions using Amazon Bedrock を翻訳したものです。

大規模な企業は、組織全体で生成 AI の力を活用するための戦略を策定しています。しかし、生成 AI の規模を拡大し、異なる事業部門 (LOB) での導入を容易にするには、データのプライバシーとセキュリティ、法的要件、コンプライアンス、運用上の課題を組織レベルで管理するという課題があります。

AWS Well-Architected Framework は、数千件のお客様との関わりから得られた AWS のベストプラクティスとガイドを活用し、大規模組織でクラウドを使用する際の課題に対応できるように開発されました。AI には、バイアスの管理、知的財産、プロンプトの安全性、データの整合性など、生成 AI ソリューションを大規模に展開する際に重要な考慮事項となる特有の課題もあります。これは新興分野であるため、ベストプラクティス、実用的なガイダンス、設計パターンを簡単に利用できる形で見つけることは困難です。本稿では、AWS Well-Architected Framework の運用上の優秀性 (operational excellence) の柱をベースラインとして、AI を安全に大規模利用するために実際のプロジェクトで開発したベストプラクティスとガイドラインを共有します。

Amazon Bedrock は、この取り組みにおいて重要な役割を果たします。これはフルマネージド型のサービスで、Anthropic、Cohere、Meta、Mistral AI、Amazon などの最先端の AI 企業が提供する高性能な基盤モデル (Foundation Model) を単一の API で利用できるほか、セキュリティ、プライバシー、責任ある AI に配慮した生成 AI アプリケーションを構築するための幅広い機能を提供します。AWS Lambda などのサービスを使用して、生成 AI 機能をアプリケーションに安全に統合およびデプロイでき、シームレスなデータ管理、モニタリング、コンプライアンスを実現できます (詳細については、モニタリングとオブザーバビリティをご参照ください)。Amazon Bedrock を使用することで、企業は以下を実現できます:

- 拡張性 – 事業部門横断で生成 AI アプリケーションをデプロイ

- セキュリティとコンプライアンス – 業界標準と規制に準拠したデータプライバシー、セキュリティ、コンプライアンスを実施

- 運用効率 – AWS Well-Architected Framework に沿った監視、ログ記録、自動化のための組み込みツールで運用を効率化

- イノベーション – 最先端の AI モデルにアクセスし、リアルタイムデータとフィードバックで継続的に改善

このアプローチにより、企業は運用上の優秀性を維持しながら、大規模に生成 AI を導入することができ、最終的に組織全体でイノベーションと効率性を推進することができます。

生成 AI ワークロードとソリューションの運用における違いは何か

Well-Architected Framework の運用上の優秀性の柱は、チームがより多くの時間を顧客に利益をもたらす新機能の構築に費やすことを支援します。この場合、安全でスケーラブルな方法での生成 AI ソリューションの開発に時間を費やすことができます。しかし、生成 AI の観点を適用する場合、その革新的な特性から生じる様々な課題と可能性に対応する必要があります。例えば、以下の側面が含まれます:

- 大規模言語モデル (LLM) が新しいコンテンツを生成する能力により、複雑性が予測できなくなる可能性がある

- モデルの学習データの透明性が欠如しているため、知的財産権の侵害が懸念される

- 生成 AI の精度が低いと、不正確または論争を招くコンテンツが作成される可能性がある

- リソースの利用には、学習やプロンプト、トークンサイズに応じて必要な大規模な計算リソースを満たすための特定の運用モデルが必要

- 継続的な学習には、追加のデータアノテーションとキュレーション戦略が必要

- コンプライアンスも急速に進化している分野であり、データガバナンスがより繊細かつ複雑になり、課題が生じる

- レガシーシステムとの統合には、互換性、システム間のデータフロー、パフォーマンスへの潜在的な影響を慎重に考慮する必要がある

そのため、生成 AI に対する観点は、これらの課題に対処し、責任ある AI 利用の基盤を提供するために、以下の要素を様々なレベルの規定と強制力を組み合わせる必要があります:

- ポリシー – 意思決定を導くための原則の体系

- ガードレール (安全境界) – ポリシーの範囲内に留めるための境界を作るルール

- メカニズム – プロセスとツール

AWS は、LLM からの有害な出力を防ぐための手段として Amazon Bedrock Guardrails を導入し、裏側の基盤モデルに関係なく、責任ある AI の出発点として追加の保護層を提供しています。しかし、生成 AI の実践者、データサイエンティスト、開発者が、確立された制御を回避するために幅広いテクノロジー、モデル、データセットを使用する可能性があるため、より包括的な組織的アプローチが重要です。

従来の IT ワークロードとアプリケーションのクラウド導入が成熟するにつれ、企業におけるクラウド利用のリスクを最小限に抑え、開発者体験を簡素化する適切なクラウドソリューションを開発者が選択できるよう支援する必要性が生まれてきました。これは一般的に プラットフォームエンジニアリング と呼ばれ、「あなた (開発者) は構築とテストを行い、プラットフォームエンジニアリングチームがそれ以外のすべてを担当します!」という考え方に要約できます。

成熟したクラウド運用モデルには、通常、クラウドの需要を生み出すことができるビジネスオフィスと、その需要をサポートするセキュリティや DevOps (CI/CD、オブザーバビリティなど) などの支援サービスを提供するプラットフォームエンジニアリングチームが含まれます。これは次の図に示されています。

生成 AI ソリューションにおいては、MLOps やプロンプトの安全性機能など、特定の AI や機械学習 (ML) プラットフォームの構成をサポートするようにサービスが拡張されます。

どこから始めるか

本稿では、運用上の優秀性の指針で定義されている基本的な運用要素について説明することから始めます。

- ビジネス成果を中心にチームを組織化:チームがビジネス成果を達成する能力は、リーダーシップのビジョン、効果的な運用、そしてビジネスに沿った運用モデルから生まれます。リーダーシップは、チームが最も効率的な方法で運用し、ビジネス成果を達成できるような適切なクラウド運用モデルを備えた CloudOps 変革に全面的に投資し、コミットする必要があります。適切な運用モデルは、人材、プロセス、テクノロジーの能力を活用して、スケールを実現し、生産性を最適化し、俊敏性 (agility)、即応性 (responsiveness)、適応性 (adaptation) を通じて差別化を図ります。組織の長期的なビジョンは、ステークホルダーやクラウドサービスの利用者に向けて企業全体に伝達される目標に変換されます。目標と運用 KPI はすべてのレベルで整合性が取れているべきです。この実践により、以下の設計原則の実装から得られる長期的な価値が維持されます。

- 実践的な知見を得るためのオブザーバビリティの実装:ワークロードの動作、パフォーマンス、信頼性、コスト、健全性を包括的に理解する必要があります。重要業績評価指標 (KPI) を確立し、オブザーバビリティのテレメトリーを活用して、十分な情報に基づいた意思決定を行い、ビジネス成果が危険にさらされた場合に迅速に行動を起こしましょう。実用的なオブザーバビリティデータに基づいて、パフォーマンス、信頼性、コストを積極的に改善しましょう。

- 可能な限り安全に自動化:クラウドでは、アプリケーションコードに使用するのと同じエンジニアリング規律を環境全体に適用できます。ワークロード全体とその運用 (アプリケーション、インフラストラクチャー、構成、手順) をコードとして定義し、更新することができます。その後、イベントに応じてワークロードの運用を開始することで自動化できます。クラウドでは、レート制御、エラー閾値、承認などのガードレールを構成することで、自動化の安全性を確保できます。効果的な自動化により、イベントへの一貫した対応、人的エラーの制限、オペレーターの負担軽減を実現できます。

- 頻繁で小規模な、元に戻せる変更を行う:コンポーネントを定期的に更新できるよう、スケーラブルで疎結合なワークロードを設計すべきです。自動化されたデプロイ技術と小規模な段階的な変更により、障害が発生した場合の影響範囲が制限され、より迅速な復旧が可能になります。これにより、品質を維持しながらワークロードに有益な変更を加え、市場状況の変化に素早く適応する自信が高まるでしょう。

- 運用手順を頻繁に改善:ワークロードの進化に合わせて、運用も適切に進化させるべきです。運用手順を使用する中で、改善の機会を探しましょう。定期的なレビューを実施し、すべての手順が効果的であり、チームがそれらに精通していることを確認しましょう。ギャップが特定された場合は、それに応じて手順を更新しましょう。手順の更新をすべてのステークホルダーとチームに伝達しましょう。運用を楽しく学べる形にしてベストプラクティスを共有し、チームを教育しましょう。

- 障害を予測:ワークロードのリスク特性とビジネス成果への影響を理解するために、障害シナリオを検証することで運用の成功を最大化しましょう。これらのシミュレートされた障害に対する手順の有効性とチームの対応をテストしましょう。テストによって特定された未解決のリスクを管理するために、十分な情報に基づいた意思決定を行いましょう。

- すべての運用イベントとメトリクスから学ぶ:すべての運用イベントと障害から得られた教訓を通じて改善を推進しましょう。得られた知見をチーム間および組織全体で共有しましょう。共有する内容には、運用がビジネス成果にどのように貢献するかについてのデータと事例を含める必要があります。

- マネージドサービスを使用:可能な限り AWS マネージドサービスを使用して運用の負担を軽減しましょう。これらのサービスとの相互作用を中心に運用手順を構築しましょう。

生成 AI プラットフォームチームは、概念実証やプロトタイプフェーズから本番環境対応のソリューションへと移行する際の重要な点に注力する必要があります。具体的には、モデルの安全な開発、デプロイ、監視の方法について説明し、運用上およびコンプライアンス上のリスクを軽減することで、AI を大規模に本番環境で採用する際の障壁を低減する方法を説明します。

まず、以下の設計原則に焦点を当てます。

- 実行可能な知見を得るためのオブザーバビリティの実装 (Implement observability for actionable insights)

- 可能な限り安全に自動化 (Safely automate where possible)

- 頻繁で小規模な、元に戻せる変更を行う (Make frequent, small, reversible changes)

- 運用手順を頻繁に改善 (Refine operations procedures frequently)

- すべての運用イベントとメトリクスから学ぶ (Learn from all operational events and metrics)

- マネージドサービスを使用 (Use managed services)

以下のセクションでは、アーキテクチャー図を使用しながら、統制の柱のベストプラクティスについて詳しく説明します。

メトリクス、ログ、トレースを活用してモデル、ガードレール、コストを透明化し制御する

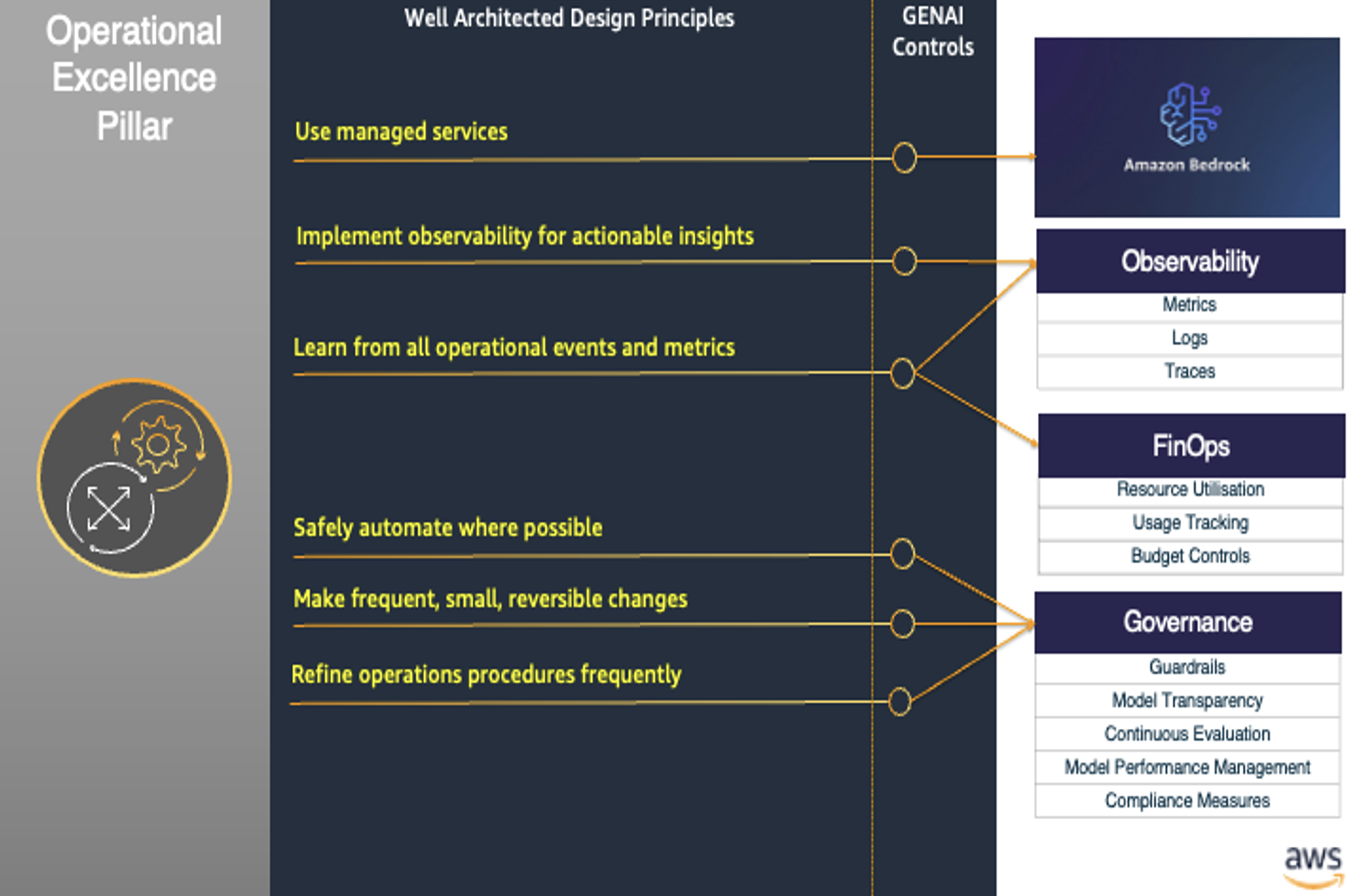

生成 AI フレームワークの統制の柱は、可視性、コスト管理、ガバナンスに焦点を当て、企業が生成 AI ソリューションを安全かつ効率的にデプロイ・運用できるようにします。次の図は、この柱の主要な構成要素を示しています。

オブザーバビリティ

監視体制の構築は、FinOps とガバナンスという他の 2 つのコンポーネントの基盤を築きます。オブザーバビリティは、生成 AI ソリューションのパフォーマンス、信頼性、コスト効率を監視する上で重要です。Amazon CloudWatch、AWS CloudTrail、Amazon OpenSearch Service などの AWS サービスを使用することで、企業はモデルのメトリクス、使用パターン、潜在的な問題について可視性を確保でき、予防的な管理と最適化が可能になります。

Amazon Bedrock は、ML モデルとアプリケーションを監視・管理するための堅牢なオブザーバビリティ機能と互換性があります。CloudWatch で収集される主要なメトリクスには、呼び出し回数、レイテンシー、クライアントおよびサーバーエラー、スロットル、入出力トークン数などが含まれます (詳細については、Monitoring the performance of Amazon Bedrock をご覧ください)。また、Amazon EventBridge を使用して Amazon Bedrock に関連するイベントを監視することもできます。これにより、特定のイベントが発生した際に特定のアクションを実行するルールを作成でき、監視構成の自動化と応答性を向上させることができます。CloudTrail は、AWS 環境内のユーザー、ロール、または AWS サービスによって Amazon Bedrock に対して行われたすべての API 呼び出しをログに記録できます。これは、個人を特定できる情報 (PII)、モデルの更新、その他の重要なアクティビティなどの機密リソースへのアクセスを追跡するのに特に有用で、企業は堅牢な監査証跡 (Audit Trail) とコンプライアンスを維持できます。詳細については、Log Amazon Bedrock API calls using AWS CloudTrail をご覧ください。

Amazon Bedrock は、LLM のオブザーバビリティ成熟度モデルを実装するために必要なメトリクスとテレメトリーをサポートしており、以下が含まれます:

- CloudWatch を通じて、モデルのパフォーマンス、プロンプトの属性情報、コストに関する指標などの LLM 固有のメトリクスを取得し分析

- LLM 関連の問題に特化したアラートとインシデント管理の実装

- Amazon Bedrock は一般的なコンプライアンス基準の対象範囲であり、自動化された不正利用検出メカニズムを提供するため、セキュリティコンプライアンスと堅牢な監視メカニズムを提供

- CloudWatch と CloudTrail を使用した異常検出、使用量とコストの予測、パフォーマンスの最適化、リソース使用率の監視

- より良いリソース計画とコスト管理のための AWS 予測サービスの使用

CloudWatch は、AWS サービスやオンプレミスのソースからログ、メトリクス、イベントを収集する、統合された監視とオブザーバビリティのサービスを提供します。これにより、企業は I/O ボリューム、レイテンシー、エラー率など、生成 AI モデルの主要性能指標 (KPI) を追跡できます。CloudWatch ダッシュボードを使用してカスタムの可視化とアラートを作成でき、チームは異常やパフォーマンスの低下を迅速に検知できます。

より高度なオブザーバビリティ要件に対しては、企業は OpenSearch と Kibana のデプロイ、運用、スケーリングを行うフルマネージドサービスである Amazon OpenSearch Service を利用できます。Opensearch Dashboards は強力な検索と分析機能を提供し、チームは生成 AI モデルの動作、ユーザーとの対話、システム全体のメトリクスをより深く掘り下げることができます。

さらに、モデル呼び出しのログ記録を有効にすることで、AWS アカウントにおけるすべての Amazon Bedrock モデル API 呼び出しの呼び出しログ、完全なリクエストレスポンスデータ、およびメタデータを収集できます。呼び出しログを有効にする前に、Amazon Simple Storage Service (Amazon S3) または CloudWatch Logs の出力先を設定する必要があります。呼び出しログは、AWS Management Console または API を通じて有効にできます。デフォルトでは、ログ記録は無効になっています。

コスト管理と最適化 (FinOps)

生成 AI ソリューションは急速にスケールし、大量のクラウドリソースを消費する可能性があるため、効果的なコスト管理の実践が不可欠です。AWS Cost Explorer や AWS Budgets などのサービスを使用することで、企業は使用状況を追跡し、生成 AI の支出を最適化して、コスト効率の良いデプロイと規模拡大を実現できます。

Cost Explorer は詳細なコスト分析と予測機能を提供し、テナントに関連する支出を理解し、コストの発生源を特定し、将来の成長を計画することができます。チームはカスタムのコスト配分レポートを作成し、AWS Budgets とアラートを使用してカスタムの予算を設定し、時間の経過に伴うコストの傾向を分析できます。

生成 AI モデルのコストとパフォーマンスの分析は、モデルのデプロイと最適化に関する適切な意思決定を行う上で重要です。

EventBridge、CloudTrail、CloudWatch は、これらのメトリクスを追跡・分析するために必要なツールを提供し、企業がデータに基づく意思決定を行うことを支援します。この情報を活用することで、十分に活用されていないリソースのスケールダウンなど、最適化の機会を特定できます。

EventBridge を使用すると、Amazon Bedrock のステータス変更イベントに自動的に応答するように Amazon Bedrock を設定できます。これにより、API レート制限の問題、API の更新、追加のコンピューティングリソースの削減に対応できます。詳細については、Amazon EventBridge での Amazon Bedrock イベントのモニタリングを参照してください。

前のセクションで説明したように、CloudWatch は Amazon Bedrock を監視して生データを収集し、読みやすいリアルタイムに近いコスト指標に処理することができます。CloudWatch コンソールを使用してメトリクスをグラフ化できます。また、特定のしきい値を監視するアラームを設定し、値がそのしきい値を超えた場合に通知を送信したり、アクションを実行したりすることもできます。

ガバナンス

エンタープライズ環境における生成 AI ソリューションの責任ある効果的な導入には、継続的な評価や複数層のガードレールなど、堅牢なガバナンス対策の実装が不可欠です。それぞれについて見ていきましょう。

- パフォーマンスのモニタリングと評価 – 生成 AI モデルのパフォーマンス、安全性、コンプライアンスを継続的に評価することは重要です。これは以下のような方法で実現できます:

- 企業は Amazon SageMaker Model Monitor や Amazon Bedrock のガードレール、Amazon Comprehend などの AWS サービスを使用して、モデルの動作をモニタリングし、ドリフトの検知を行い、生成 AI ソリューションが期待通り (またはそれ以上) に機能し、組織のポリシーを遵守していることを確認できます。

- RAGAS などのオープンソースの評価指標をカスタムメトリクスとしてデプロイし、LLM のレスポンスが適切な根拠に基づいているか、バイアスを軽減し、ハルシネーション (幻覚) を防止できているかを確認できます。

- モデル評価ジョブ を使用すると、モデルの出力を比較し、ユースケースに最適なモデルを選択できます。このジョブは、正解データに基づいて自動化することも、専門知識を持つ人間が評価することもできる。また、Amazon Bedrock の基盤モデル を使用してアプリケーションを評価することもできます。このアプローチについて詳しくは、Amazon Bedrock を使用した検索拡張生成アプリケーションの信頼性評価を参照してください。

- ガードレール – 生成 AI ソリューションには、責任ある AI と監視を実施するための堅牢な多層的ガードレールを含める必要があります:

- まず、バイアスのリスクを軽減し、責任ある AI ポリシーでアプリケーションを保護するために、LLM モデルの周りにガードレールが必要です。これは、Amazon Bedrock のガードレールを使用して、モデル (基盤モデルまたは微調整済み) の周りにカスタムガードレールを設定し、禁止トピック、コンテンツフィルター、ブロックされたメッセージを構成することで実現できます。

- 第二のレベルは、各ユースケースのフレームワークの周りにガードレールを設定することです。これには、アクセス制御、データガバナンスポリシー、予防的なモニタリングとアラートの実装が含まれ、機密情報が適切に保護され監視されることを確実にします。例えば、データウェアハウジングには Amazon Redshift、データ統合には AWS Glue、ビジネスインテリジェンス (BI) には Amazon QuickSight などの AWS データ分析サービスを使用できます。

- コンプライアンス対策 – 企業は、GDPR、CCPA、または業界固有の基準などの規制要件や業界標準を満たすための堅牢なコンプライアンスフレームワークを設定する必要があります。これにより、生成 AI ソリューションが様々なユースケースで機密情報を安全かつ効率的に処理し、コンプライアンスを維持できます。このアプローチにより、データ漏洩や不正アクセスのリスクを最小限に抑え、重要なデータ資産の整合性と機密性を保護します。企業は、包括的なガバナンス構造を作成するために、以下の組織レベルのアクションを取ることができます:

- コンプライアンス違反や AI システムの誤動作に対応するための明確なインシデント対応計画を確立します。

- 定期的なコンプライアンス評価とサードパーティ監査を実施し、潜在的なリスクや違反を特定して対処します。

- 従業員に対して、コンプライアンス要件と AI ガバナンスのベストプラクティスに関する継続的なトレーニングを提供します。

- モデルの透明性 – 生成 AI モデルの完全な透明性の実現は依然として課題ですが、組織はモデルの透明性と説明可能性を高めるために以下のようなステップを取ることができます:

- モデルの使用目的、パフォーマンス、機能、潜在的なバイアスについてのモデルカードを提供します。

- モデルに自己説明を求める、つまり自身の判断に対する説明を提供させます。これは複雑なシステムでも設定できます。例えば、エージェントが複数ステップの計画を実行し、自己説明を通じて改善することができます。

LLMOps または FMOps によるモデルライフサイクル管理の自動化

LLMOps の実装は、生成 AI モデルのライフサイクルを大規模に効率的に管理するために重要です。FMOps のサブセットである LLMOps の概念と、MLOps との主な違いについては、FMOps/LLMOps: 生成 AI の実運用と MLOps との違いをご覧ください。このブログ記事では、生成 AI アプリケーションの開発ライフサイクルと、生成 AI アプリケーションを実運用するために必要な追加のスキル、プロセス、技術について詳しく説明しています。

データ取り込みと利用における標準的な管理手法

LLM に新しいデータを追加して強化することは、大規模な微調整や企業独自の LLM を構築する負担なしに、より文脈に沿った回答を提供するために不可欠です。データの取り込み、抽出、変換、カタログ化、ガバナンスの管理は、企業のデータポリシーとガバナンスフレームワークに準拠する必要がある複雑で時間のかかるプロセスです。

AWS はこれらをサポートするいくつかのサービスを提供しています。以下の図は、これらの概要を示しています。

詳細については、Scaling AI and Machine Learning Workloads with Ray on AWS および Build a RAG data ingestion pipeline for large scale ML workloads をご参照ください。

このワークフローには、以下の手順が含まれます。

- データは、カスタムツールや既存のツール、または AWS Transfer を使用して AWS に安全に転送できます。AWS Identity and Access Management (IAM) と AWS PrivateLink を使用してデータと生成 AI リソースへのアクセスを制御・保護し、データが組織の境界内に留まり、関連規制に準拠することを確実にできます。

- データが Amazon S3 に格納されたら、AWS Glue を使用してデータの抽出と変換 (例えば Parquet 形式への変換) を行い、取り込んだデータに関するメタデータを保存してデータガバナンスとカタログ化を容易にできます。

- 3 つ目のコンポーネントは GPU クラスターで、これは Ray クラスターを利用できます。AWS Step Functions、Amazon SageMaker Pipelines、または AWS Batch などの様々なオーケストレーションエンジンを使用して、埋め込みを作成し、データをデータストアやベクトルストアに取り込むためのジョブ (またはパイプライン) を実行できます。

- 埋め込みは OpenSearch などのベクトルストアに保存でき、効率的な検索とクエリが可能になります。あるいは、Amazon Bedrock Knowledge Bases のようなソリューションを使用して Amazon S3 やその他のデータソースからデータを取り込み、生成 AI ソリューションとシームレスに統合することができます。

- Amazon DataZone を使用して、Amazon S3 とベクトルストアに保存された生データへのアクセス制御を管理し、データガバナンスのためのロールベースまたは細粒度のアクセス制御を実施できます。

- データの意味的な理解が必要な場合は、Amazon Kendra を使用してインテリジェントな企業検索を実現できます。Amazon Kendra には ML 機能が組み込まれており、S3 などの様々なデータソースと簡単に統合でき、組織のニーズに応じて適応可能です。

使用するコンポーネントの選択は、ソリューションの具体的な要件によって異なりますが、すべてのデータ管理をブループリントにコード化できるよう (次のセクションで説明)、一貫したソリューションが存在する必要があります。

モデル、プロンプトカタログ、API、アクセス制御ガイドラインのための管理型インフラストラクチャーパターンとブループリントの提供

生成 AI ソリューションを構築・デプロイする方法は数多くあります。AWS は Amazon Bedrock、Amazon Kendra、OpenSearch Service などの主要サービスを提供しており、これらはテキスト要約や検索拡張生成 (RAG) などの複数の生成 AI のユースケースをサポートするように構成できます。

最も簡単な方法は、生成 AI を必要とする各チームが AWS 上で独自のカスタムソリューションを構築できるようにすることですが、これは必然的にコストを増加させ、組織全体で不整合を引き起こすことになります。より拡張性の高いオプションは、統括チームがブループリントやコンストラクトにコード化された標準的な生成 AI ソリューションを構築し、各チームがそれらをデプロイして使用できるようにすることです。このチームは、使いやすく統合された API でこれらのコンストラクトを抽象化するプラットフォームを提供し、LLMOps、データ管理、FinOps などの追加サービスを提供することができます。次の図は、これらのオプションを示しています。

LangChain や LiteLLM などの生成 AI のランタイム、API、プロンプト、オーケストレーションのためのブループリントとコンストラクトを確立することで、生成 AI の導入が簡素化され、全体的な安全な利用が促進されます。アクセス制御、一貫性のある AI、データとコストの管理を備えた標準 API を提供することで、利用が簡単で、コスト効率が良く、セキュアな利用が可能になります。

AWS 上でソリューションを構築する際のマルチテナントアーキテクチャにおけるリソースの分離の強制方法や、分離戦略における重要なパターンについての詳細は、ホワイトペーパー SaaS Tenant Isolation Strategies を参照してください。

まとめ

Well-Architected Framework の運用上の優秀性の柱を生成 AI の観点から重視することで、企業は安全で費用対効果が高くコンプライアンスに準拠したソリューションを構築し、生成 AI の取り組みを自信を持ってスケールできます。生成 AI のランタイム、プロンプト、オーケストレーションに標準化された基本フレームワークを導入することで、組織は既存のワークフローに生成 AI の機能をシームレスに統合できるようになります。

次のステップとして、予防的なモニタリングとアラートを設定することで、バイアスのある出力や有害な出力の生成など、潜在的な問題を迅速に検出して軽減できるようになります。

受け身で待つ必要はありません。ベストプラクティスを採用するために、積極的な姿勢で取り組みましょう。倫理的な AI の実践を維持するため、生成 AI システムの定期的な監査を実施してください。生成 AI の運用における優れた実践に関する技術について、チームのトレーニングに投資してください。これらのアクションを今すぐ実行することで、この技術の複雑さに賢明に対処しながら、生成 AI の変革的な可能性を活用する準備が整います。

著者について

Akarsha Sehwag は、AWS プロフェッショナルサービスのデータサイエンティストおよび ML エンジニアで、ML ベースのサービスと製品の構築に 5 年以上の経験を持っています。コンピュータビジョンとディープラーニングの専門知識を活かし、お客様が AWS クラウドで ML の能力を効率的に活用できるよう支援しています。生成 AI の登場により、多くのお客様と協力して適切なユースケースを特定し、本番環境で利用可能なソリューションを構築してきました。開発、起業家精神、研究など、幅広い分野に関心を持っています。

Akarsha Sehwag は、AWS プロフェッショナルサービスのデータサイエンティストおよび ML エンジニアで、ML ベースのサービスと製品の構築に 5 年以上の経験を持っています。コンピュータビジョンとディープラーニングの専門知識を活かし、お客様が AWS クラウドで ML の能力を効率的に活用できるよう支援しています。生成 AI の登場により、多くのお客様と協力して適切なユースケースを特定し、本番環境で利用可能なソリューションを構築してきました。開発、起業家精神、研究など、幅広い分野に関心を持っています。

Malcolm Orr は AWS のプリンシパルエンジニアで、AWS サービスを使用したプラットフォームと分散システムの構築に長年の経験を持っています。構造化されたシステム的な視点で生成 AI に取り組み、組織全体で安全、セキュア、かつコスト効率的に生成 AI を導入する方法の定義を支援しています。

Malcolm Orr は AWS のプリンシパルエンジニアで、AWS サービスを使用したプラットフォームと分散システムの構築に長年の経験を持っています。構造化されたシステム的な視点で生成 AI に取り組み、組織全体で安全、セキュア、かつコスト効率的に生成 AI を導入する方法の定義を支援しています。

Tanvi Singhal は AWS プロフェッショナルサービスのデータサイエンティストです。データサイエンス、機械学習、ビッグデータが専門分野です。クラウド環境での機械学習モデルと MLOps ソリューションの開発においてお客様をサポートしています。AWS 入社前は、配車サービス、小売、金融サービスなど、さまざまな業界でコンサルタントを務めていました。お客様のクラウドにおけるデータ/AI の取り組みを支援することに情熱を注いでいます。

Tanvi Singhal は AWS プロフェッショナルサービスのデータサイエンティストです。データサイエンス、機械学習、ビッグデータが専門分野です。クラウド環境での機械学習モデルと MLOps ソリューションの開発においてお客様をサポートしています。AWS 入社前は、配車サービス、小売、金融サービスなど、さまざまな業界でコンサルタントを務めていました。お客様のクラウドにおけるデータ/AI の取り組みを支援することに情熱を注いでいます。

Zorina Alliata は主席 AI 戦略担当として、人工知能と機械学習を活用して業務を迅速化しプロセスを強化するソリューションをグローバルなお客様と共に見出し、さまざまな業界の企業における AI ユースケース、プラットフォーム、AI の大規模実装に向けた戦略と実行計画の策定を支援しています。

Zorina Alliata は主席 AI 戦略担当として、人工知能と機械学習を活用して業務を迅速化しプロセスを強化するソリューションをグローバルなお客様と共に見出し、さまざまな業界の企業における AI ユースケース、プラットフォーム、AI の大規模実装に向けた戦略と実行計画の策定を支援しています。

翻訳は機械学習ソリューションアーキテクトの本橋が担当しました。