Amazon Web Services ブログ

TwelveLabs の動画理解モデルが Amazon Bedrock で利用可能に

2025年の初めに、TwelveLabs の動画理解モデルが Amazon Bedrock で利用可能になる予定であることを事前にお知らせしました。7 月 15 日、これらのモデルが動画の検索、シーンの分類、要約、正確かつ信頼性の高いインサイトの抽出にご利用いただけるようになったことをお知らせします。

TwelveLabs は、検索や分類などのタスクを効率的に実行できる動画埋め込みモデルである Marengo と、動画データに基づいてテキストを生成できる動画言語モデルである Pegasus を発表しました。これらのモデルは、Amazon SageMaker HyperPod でトレーニングされており、テキスト要約、メタデータの生成、クリエイティブの最適化を提供する画期的な動画分析を可能にします。

Amazon Bedrock で TwelveLabs モデルを使用すると、「試合の最初のタッチダウンを見せて」や「主要なキャラクターたちが初めて出会うシーンを見つけて」など、自然言語による動画検索機能を使用して特定の場面を見つけて、まさにその場面に瞬時にジャンプできます。また、タイトル、トピック、ハッシュタグ、要約、章、ハイライトなどの説明テキストを生成することで動画コンテンツを理解するアプリケーションを構築して、事前定義済みのラベルやカテゴリを必要とせずにインサイトやつながりを明らかにすることもできます。

例えば、顧客からのフィードバックに繰り返し現れるテーマを見つけたり、以前は明らかではなかった製品の使用パターンを特定したりできます。数百時間または数千時間に及ぶ動画コンテンツをお持ちでも、エンタープライズグレードのセキュリティとパフォーマンスを維持しながら、ライブラリ全体を検索可能なナレッジリソースに変換できます。

TwelveLabs が公開した Marengo と Pegasus の動画をご覧ください。

これらのモデルを活用することで、業界を問わず動画ワークフローを変革できます。メディア制作者や編集者は、特定のシーンや会話を瞬時に見つけることができるため、何時間もの映像を精査するのではなく、ストーリーテリングに注力できます。マーケティングチームは、さまざまなオーディエンスの心に響くコンテンツを迅速にパーソナライズすることで広告ワークフローを効率化しています。また、セキュリティチームは、複数の動画フィードにまたがるパターンを見つけることで、潜在的なリスクをプロアクティブに特定するためにこのテクノロジーを利用しています。

Amazon Bedrock での TwelveLabs モデルの開始方法

TwelveLabs モデルを初めて使用する場合は、使用を開始する前に Amazon Bedrock コンソールに移動し、左下のナビゲーションペインで [モデルアクセス] を選択します。最新の TwelveLabs モデルにアクセスするには、TwelveLabs で Marengo Embed 2.7 と Pegasus 1.2 へのアクセスをリクエストします。

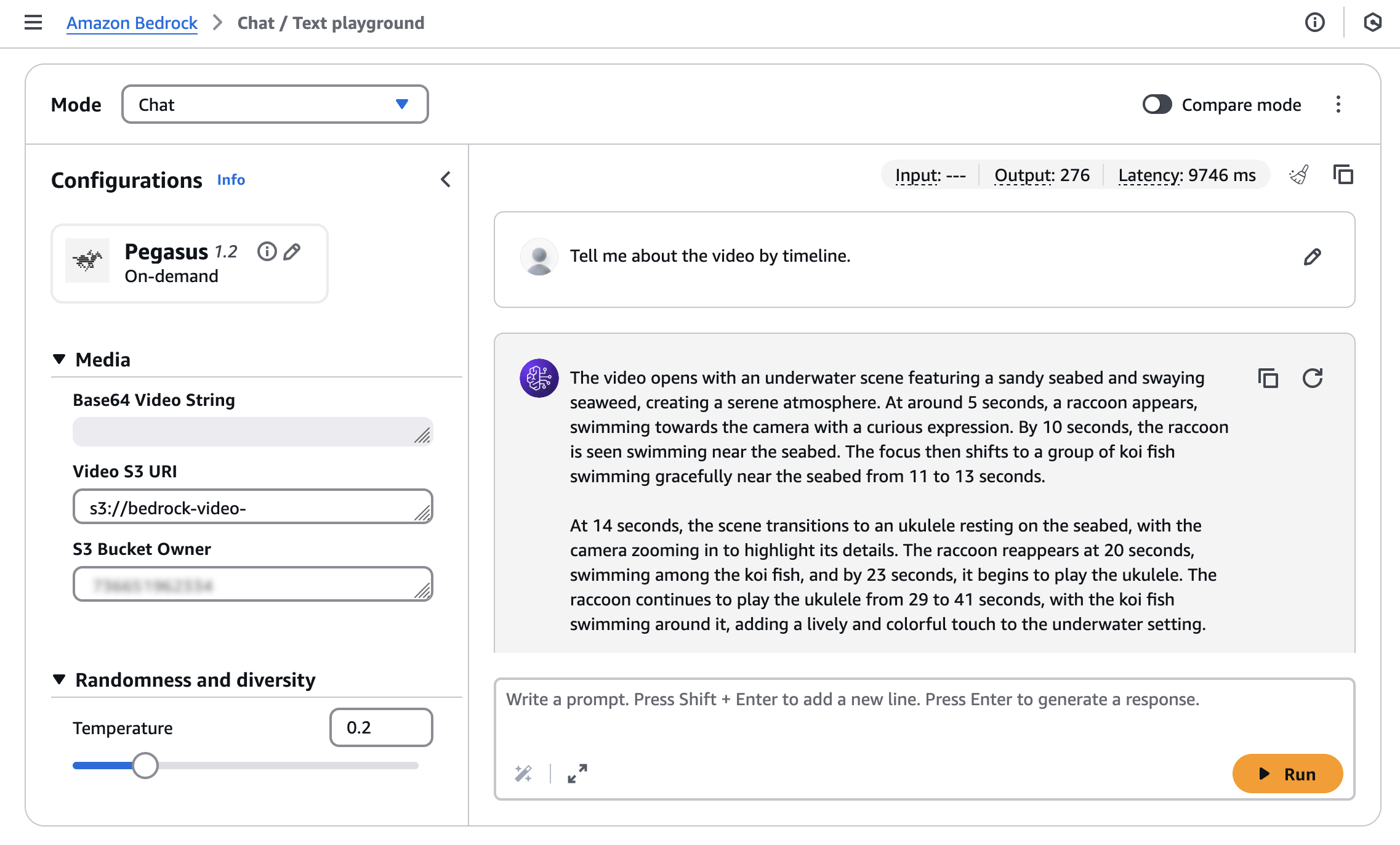

Amazon Bedrock で TwelveLabs モデルを使用するには、左側のナビゲーションペインの [テスト] で [チャット/テキストプレイグラウンド] を選択します。[モデルを選択] を選択し、カテゴリとして [TwelveLabs]、モデルとして [Pegasus] を選択して、[適用] を選択します。

動画からテキストを検索または生成するには、動画を Amazon Simple Storage Service (Amazon S3) バケットにアップロードするか、または Base64 形式の動画文字列を入力する必要があります。

Amazon Nova Reel を使用して生成されたサンプル動画と、「A cute raccoon playing guitar underwater」(水中でギターを弾くかわいいアライグマ) というプロンプトを使用します。

アップロードした動画の [S3 URI] と [S3 バケット所有者] を入力し、「Tell me about the video by timeline」(タイムライン別に動画について教えてください) というプロンプトを実行します。

次のモデル応答が得られます:

The video opens with an underwater scene featuring a sandy seabed and swaying seaweed, creating a serene atmosphere.At around 5 seconds, a raccoon appears, swimming towards the camera with a curious expression.By 10 seconds, the raccoon is seen swimming near the seabed.The focus then shifts to a group of koi fish swimming gracefully near the seabed from 11 to 13 seconds.

At 14 seconds, the scene transitions to an ukulele resting on the seabed, with the camera zooming in to highlight its details.The raccoon reappears at 20 seconds, swimming among the koi fish, and by 23 seconds, it begins to play the ukulele.The raccoon continues to play the ukulele from 29 to 41 seconds, with the koi fish swimming around it, adding a lively and colorful touch to the underwater setting.

From 42 to 49 seconds, the raccoon is shown playing the ukulele with the koi fish swimming around it.The video concludes with a screen displaying "Video generated with Amazon Novo Reel 1.1" and "Available in Amazon Bedrock" from 50 to 54 seconds, followed by the AWS logo from 55 to 57 seconds.

TwelveLabs モデルは、会話型 AI インタラクションのための統合インターフェイスを提供する Amazon Bedrock Converse API を使用して、アプリケーションに簡単に統合できます。

TwelveLabs Pegasus モデルで AWS SDK for Python (Boto3) を使用する方法の例を次に示します:

import boto3

import json

import os

AWS_REGION = "us-east-1"

MODEL_ID = "twelvelabs.pegasus-1-2-v1:0"

VIDEO_PATH = "sample.mp4"

def read_file(file_path: str) -> bytes:

"""Read a file in binary mode."""

try:

with open(file_path, 'rb') as file:

return file.read()

except Exception as e:

raise Exception(f"Error reading file {file_path}: {str(e)}")

bedrock_runtime = boto3.client(

service_name="bedrock-runtime",

region_name=AWS_REGION

)

request_body = {

"messages": [

{

"role": "user",

"content": [

{

"inputPrompt": "tell me about the video",

"mediaSource: {

"base64String": read_file(VIDEO_PATH)

}

},

],

}

]

}

response = bedrock_runtime.converse(

modelId=MODEL_ID,

messages=request_body["messages"]

)

print(response["output"]["message"]["content"][-1]["text"])TwelveLabs Marengo Embed 2.7 モデルは、動画、テキスト、音声、または画像の入力からベクトル埋め込みを生成します。これらの埋め込みは、類似性検索、クラスタリング、および他の機械学習 (ML) タスクに使用できます。このモデルは、Bedrock AsyncInvokeModel API を通じて非同期推論をサポートします。

動画ソースの場合、AsyncInvokeModel API を使用して、TwelveLabs Marengo Embed 2.7 モデル用に JSON 形式をリクエストできます。

{

"modelId": "twelvelabs.marengo-embed-2.7",

"modelInput": {

"inputType": "video",

"mediaSource": {

"s3Location": {

"uri": "s3://your-video-object-s3-path",

"bucketOwner": "your-video-object-s3-bucket-owner-account"

}

}

},

"outputDataConfig": {

"s3OutputDataConfig": {

"s3Uri": "s3://your-bucket-name"

}

}

}レスポンスは指定された S3 の場所に配信されます。

{

"embedding": [0.345, -0.678, 0.901, ...],

"embeddingOption": "visual-text",

"startSec": 0.0,

"endSec": 5.0

}使用を開始する際に役立つよう、複数のユースケースとさまざまなプログラミング言語に対応した幅広いコード例をご確認ください。詳細については、AWS ドキュメントの「TwelveLabs Pegasus 1.2」および「TwelveLabs Marengo Embed 2.7」にアクセスしてください。

今すぐご利用いただけます

TwelveLabs モデルの一般提供は、Amazon Bedrock で本日より開始されます: Marengo モデルは、米国東部 (バージニア北部)、欧州 (アイルランド)、アジアパシフィック (ソウル) リージョンで、Pegasus モデルは、米国西部 (オレゴン) および欧州 (アイルランド) リージョンで提供され、米国および欧州リージョンからクロスリージョン推論を使用してアクセスできます。今後のアップデートについては、詳細なリージョンリストをご確認ください。詳細については、Amazon Bedrock での TwelveLabs 製品ページと Amazon Bedrock の料金ページにアクセスしてください。

TwelveLabs モデルを Amazon Bedrock コンソールで今すぐお試しください。また、AWS re:Post for Amazon Bedrock 宛てに、または通常の AWS サポート担当者を通じて、ぜひフィードバックをお寄せください。

– Channy

原文はこちらです。