亚马逊AWS官方博客

Amazon Bedrock 增加了强化微调功能,简化了开发人员构建更智能、更准确的 AI 模型的方式

组织在根据特定业务需求适配 AI 模型时,常面临一个棘手的权衡:是满足于表现平平的通用模型,还是应对高级模型定制带来的复杂性与高昂成本。传统方法迫使您在以下两者间做出选择:要么使用性能较差的小模型,要么承担部署大型模型变体和管理复杂基础设施的高昂费用。强化微调是一种先进技术,它利用反馈而非海量标注数据集来训练模型。然而,实施该技术通常需要专业的机器学习知识、复杂的基础设施和大量投入,且无法保证能达到特定使用案例所需的准确度。

今天,我们宣布在 Amazon Bedrock 中推出强化微调功能。这是一项全新的模型定制能力,可创建更智能、更具成本效益的模型。这些模型能够从反馈中学习,并为特定业务需求提供更高质量的输出。强化微调采用反馈驱动的方法,模型根据奖励信号进行迭代改进,其准确率平均比基础模型提升 66%。

Amazon Bedrock 自动执行强化微调工作流,使日常开发人员无需深度机器学习 (ML) 专业知识或大型标签数据集即可使用这种先进的模型定制技术。

增强微调如何工作

强化微调基于强化学习原则构建,旨在解决一个常见挑战:使模型能够持续生成符合业务要求和用户偏好的输出。

传统的微调需要大量标注数据集和昂贵的人工标注,而强化微调则采取了不同的方法。它没有从固定的示例中学习,它并非从固定示例中学习,而是利用奖励函数来评估和判断哪些响应对于特定的业务使用案例有利。这教导模型理解构成高质量响应的要素,而无需海量预先标注的训练数据,使得 Amazon Bedrock 中的高级模型定制更易于使用且更具成本效益。

以下是使用 Amazon Bedrock 强化微调的优势:

- 易于使用 – Amazon Bedrock 可自动处理大部分复杂性,使构建 AI 应用程序的开发人员更容易进行强化微调。模型可以使用 Amazon Bedrock 中现有的 API 日志进行训练,或通过上传数据集作为训练数据,无需标注数据集或搭建基础设施。

- 更好的模型性能 – 与基础模型相比,强化微调使模型准确度平均提高 66%,通过训练更小、更快、更有效的模型变体,可以优化价格和性能。这适用于 Amazon Nova 2 Lite 模型,可为特定业务需求提升质量和性价比,并将很快支持更多模型。

- 安全性 – 在整个定制过程中,数据始终保留在安全的 AWS 环境中,从而降低了安全与合规顾虑。

该能力支持两种互补的方法,为优化模型提供了灵活性:

- •基于可验证奖励的强化学习 (RLVR) 使用基于规则的评分器处理代码生成或数学推理等客观任务。

- 基于 AI 反馈的强化学习 (RLAIF) 则采用基于 AI 的评判模型来处理遵循指令或内容审核等主观任务。

开始在 Amazon Bedrock 中使用强化微调

让我们逐步完成创建强化微调作业的过程。

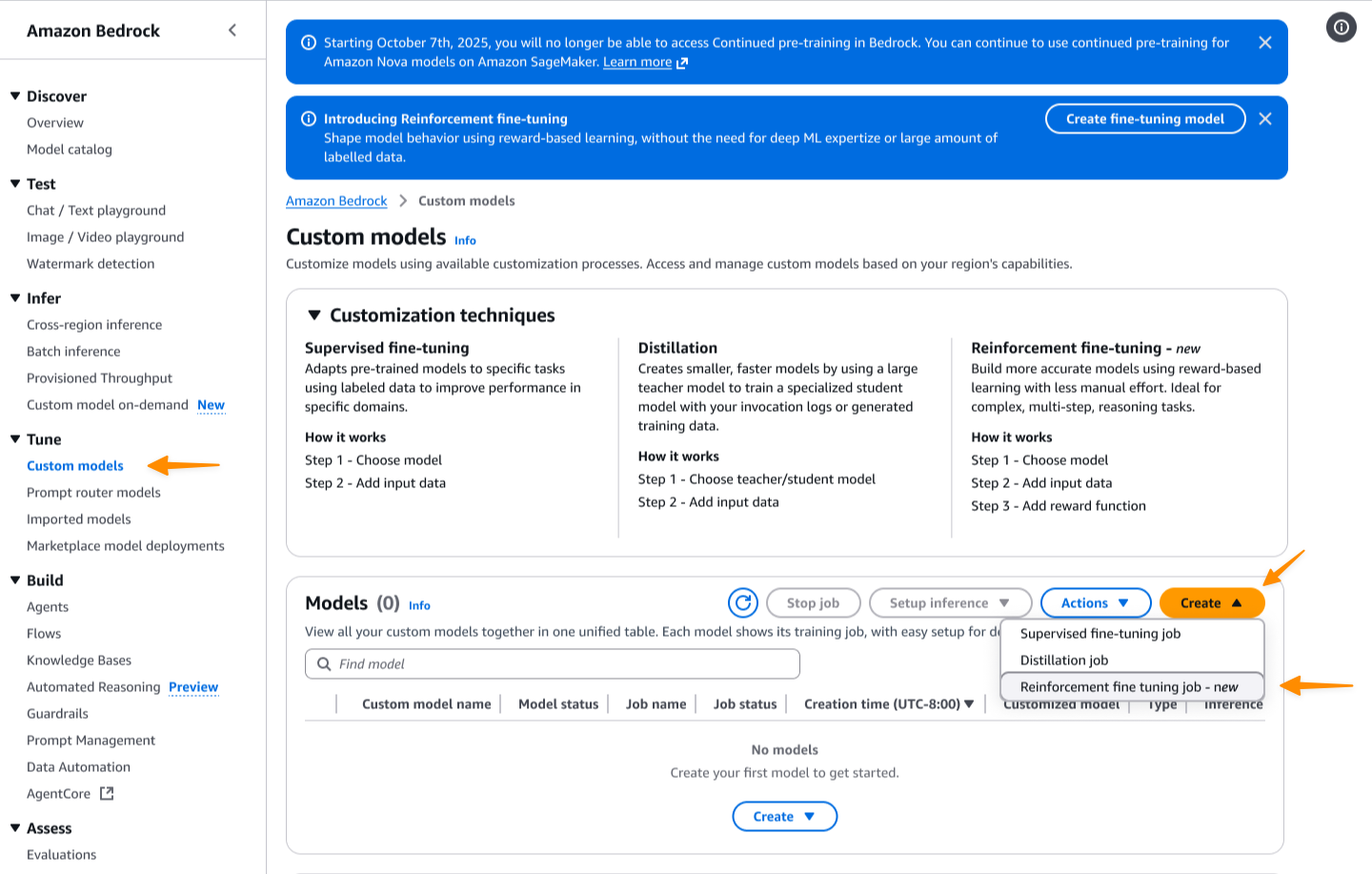

首先,我访问 Amazon Bedrock 控制台。然后,我导航到定制模型页面。我选择创建,然后选择强化微调作业。

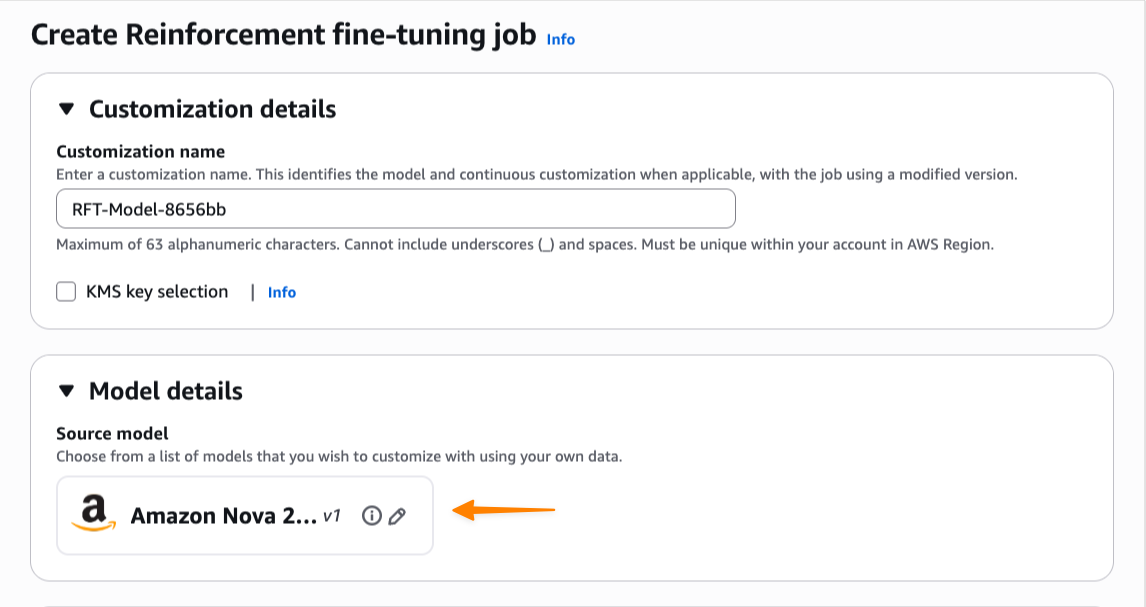

我先输入此定制任务的名称,然后选择基础模型。在发布时,强化微调支持 Amazon Nova 2 Lite,并将很快支持更多模型。

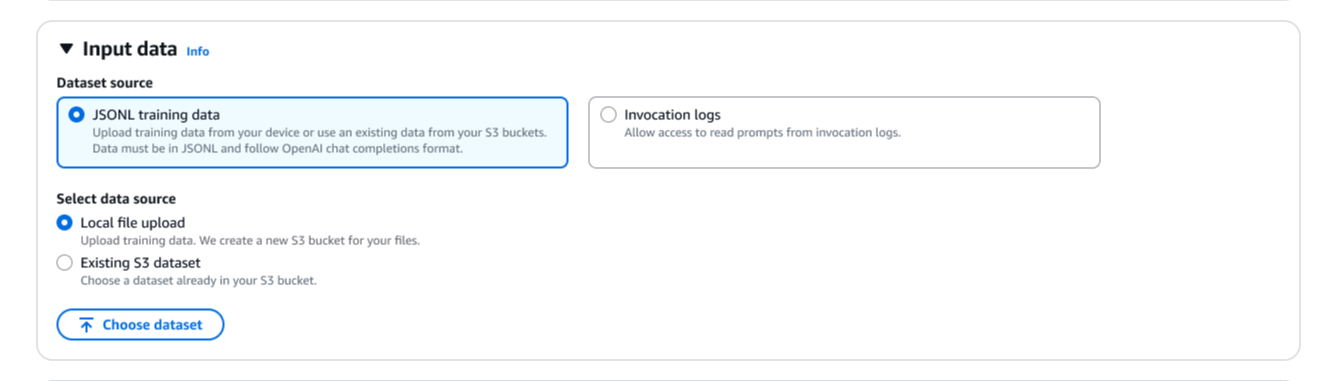

接下来,我需要提供训练数据。我可以直接使用存储的调用日志,无需上传单独的数据集。我还可以上传新的 JSONL 文件,或从 Amazon Simple Storage Service (Amazon S3) 中选择现有的数据集。强化微调会自动验证我的训练数据集,并支持 OpenAI Chat Completions 数据格式。如果我提供 Amazon Bedrock 调用或转换格式的调用日志,Amazon Bedrock 会自动将其转换为 Chat Completions 格式。

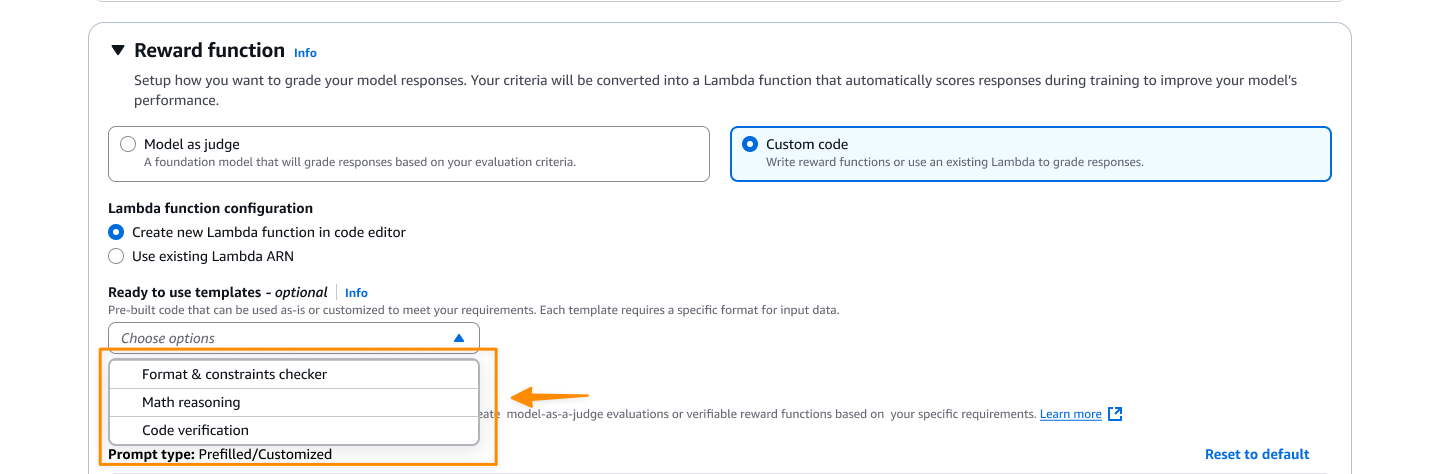

奖励函数设置环节用于定义何为良好的响应。我在此有两个选项。对于客观任务,我可以选择自定义代码并编写通过 AWS Lambda 函数执行的自定义 Python 代码。对于更主观的评测,我可以选择模型作为评判者,通过提供评测说明来使用基础模型 (FM) 作为评判者。

在这里,我选择自定义代码,然后创建一个新的 Lambda 函数或使用现有函数作为奖励函数。我可以从提供的模板之一开始,然后根据特定需求进行定制。

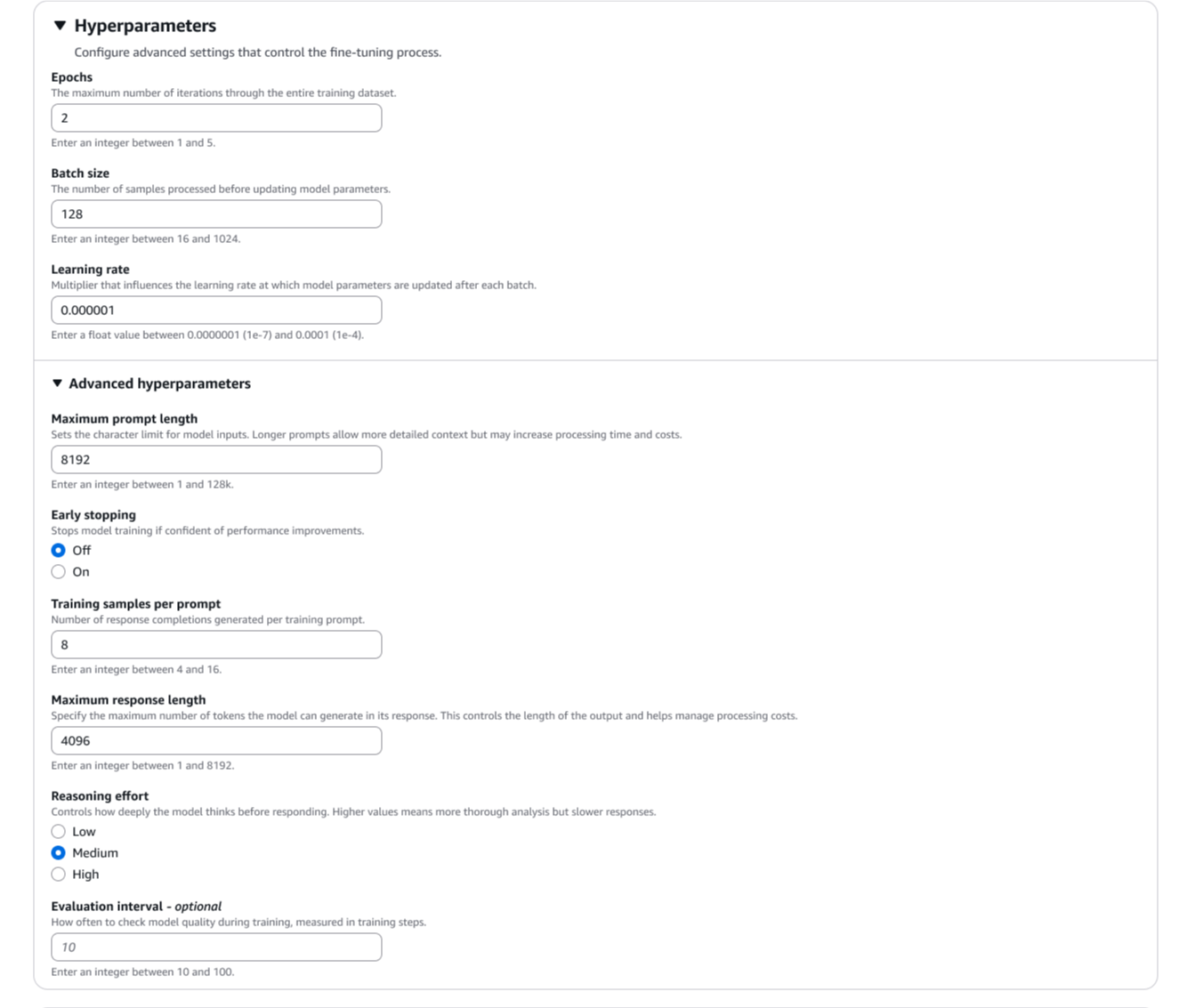

我可以选择性地修改默认的超参数,例如学习率、批次大小和 epoch。

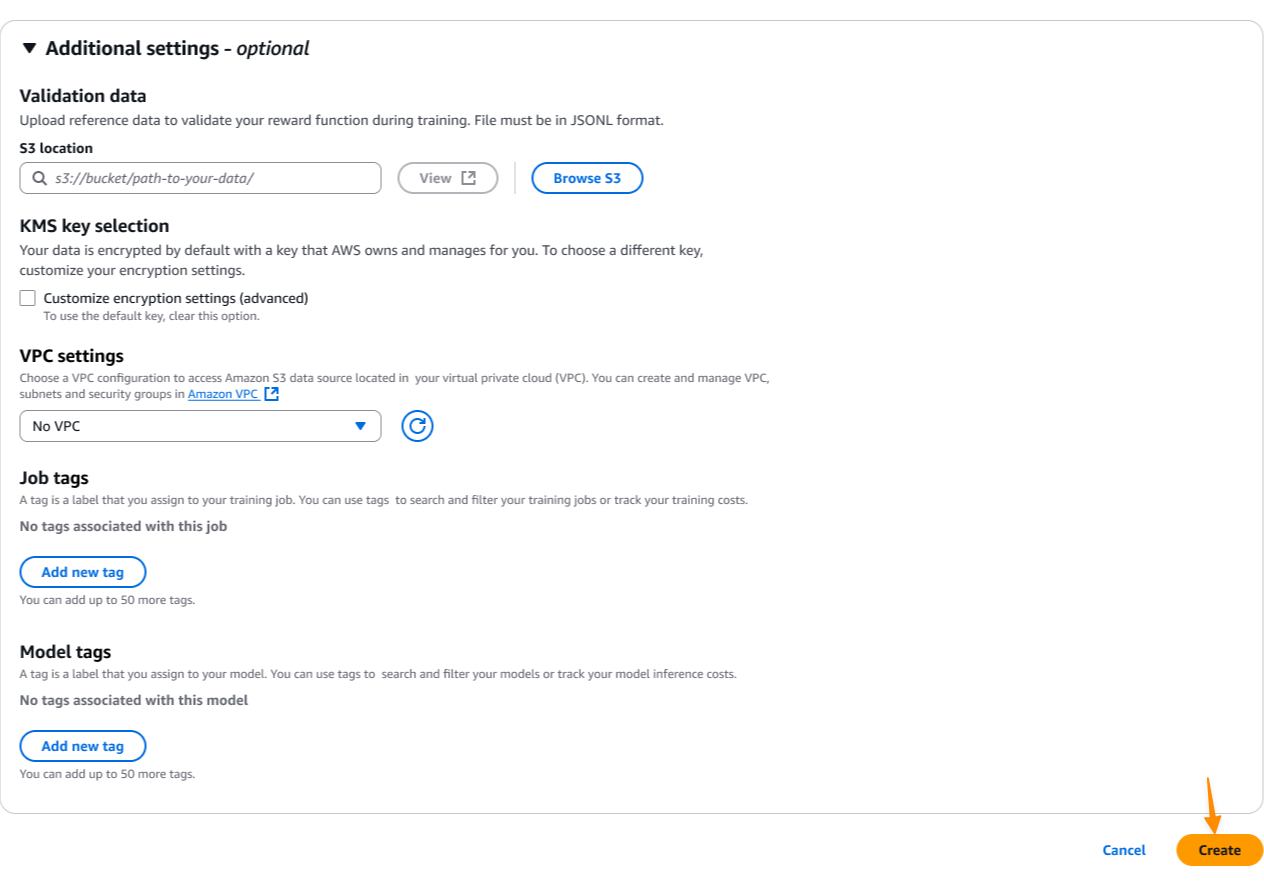

为了增强安全性,我可以配置虚拟私有云 (VPC) 设置和 AWS Key Management Service (AWS KMS) 加密,以满足我的合规要求。然后,我选择创建来启动模型定制作业。

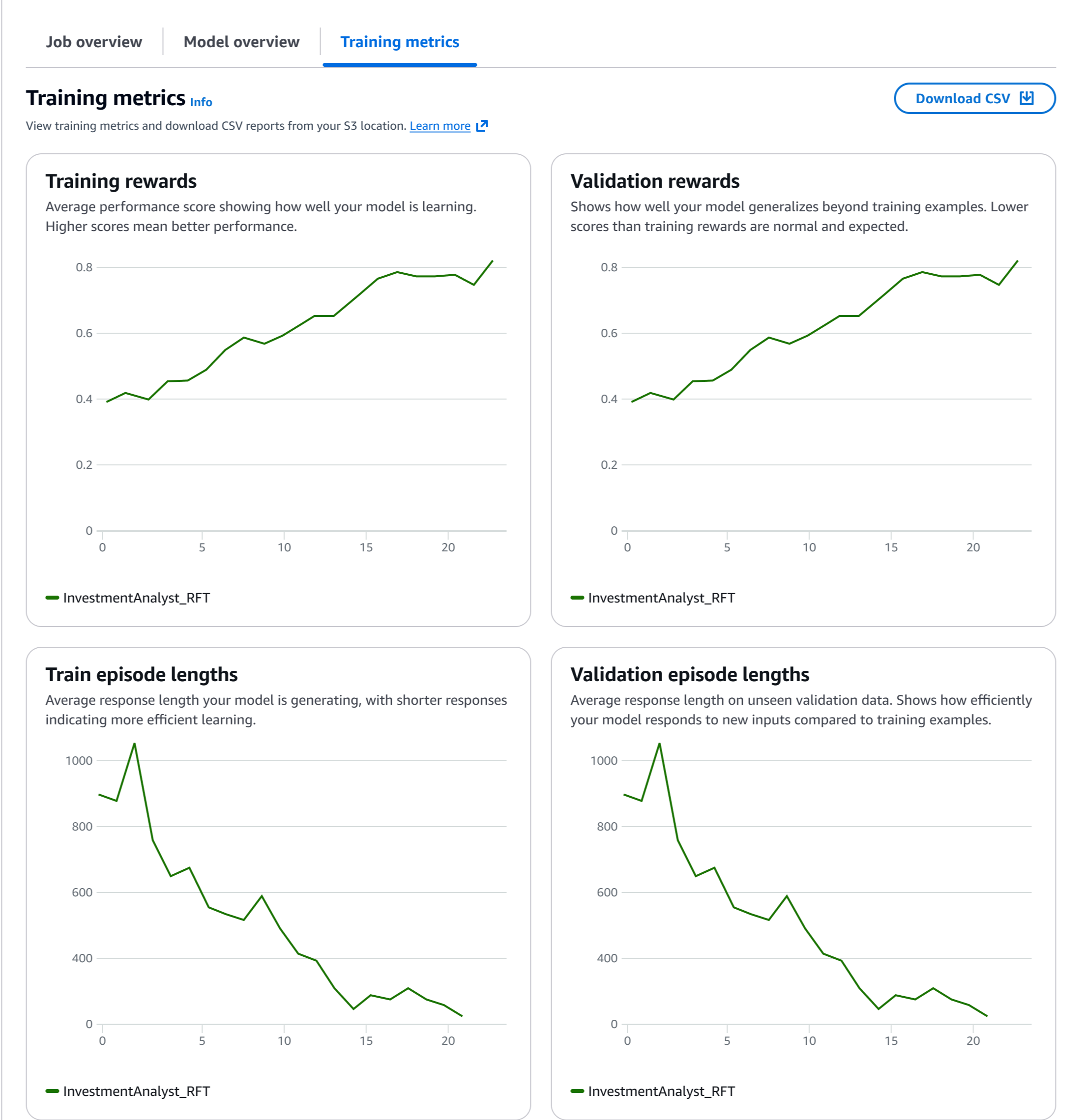

在训练过程中,我可以监控实时指标以了解模型的学习情况。训练指标仪表板显示关键性能指标,包括奖励分数、损失曲线和准确率随时间的改善情况。这些指标有助于我了解模型是否在正常收敛,以及奖励函数是否有效地指导着学习过程。

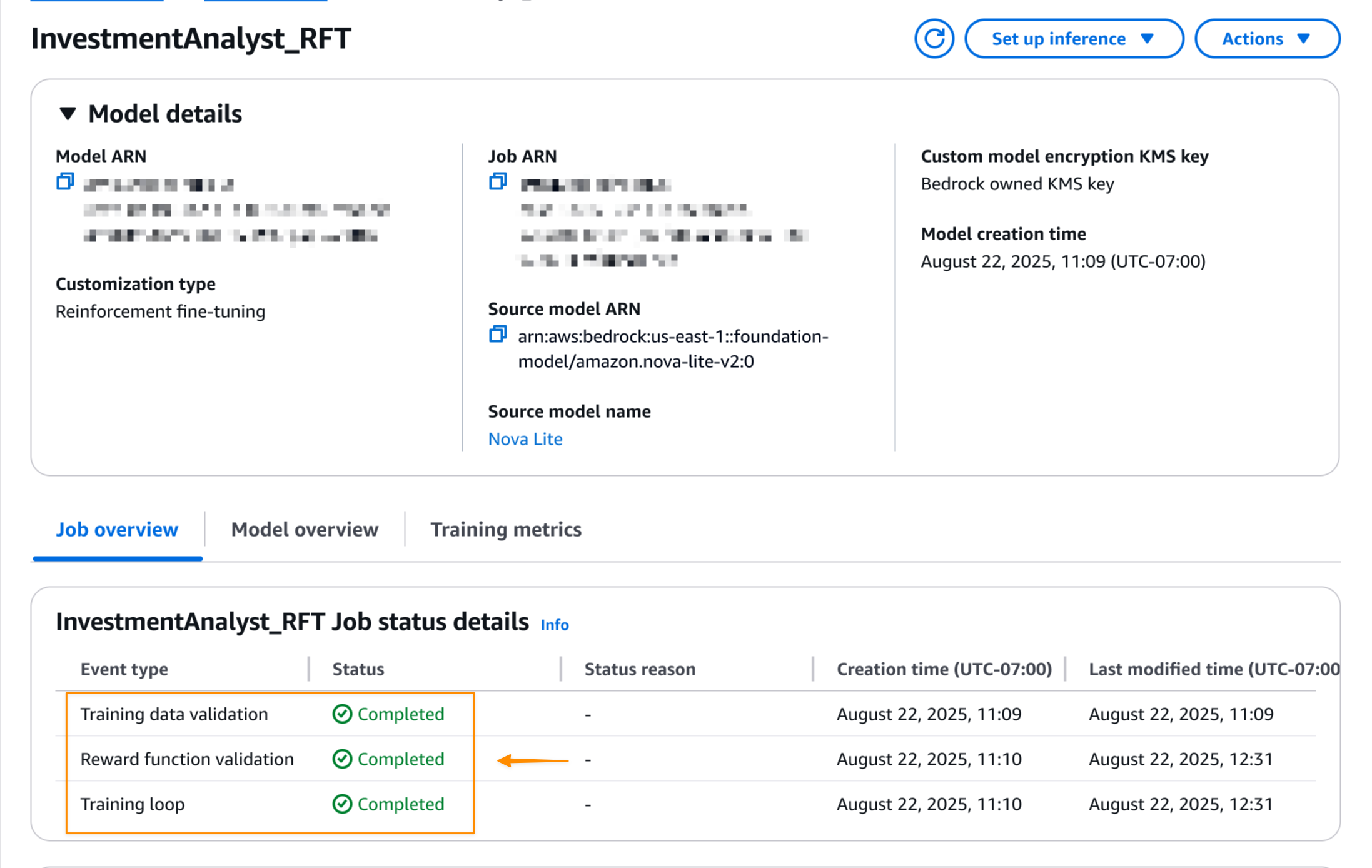

当强化微调任务完成后,我可以模型详细信息页面上看到最终的作业状态。

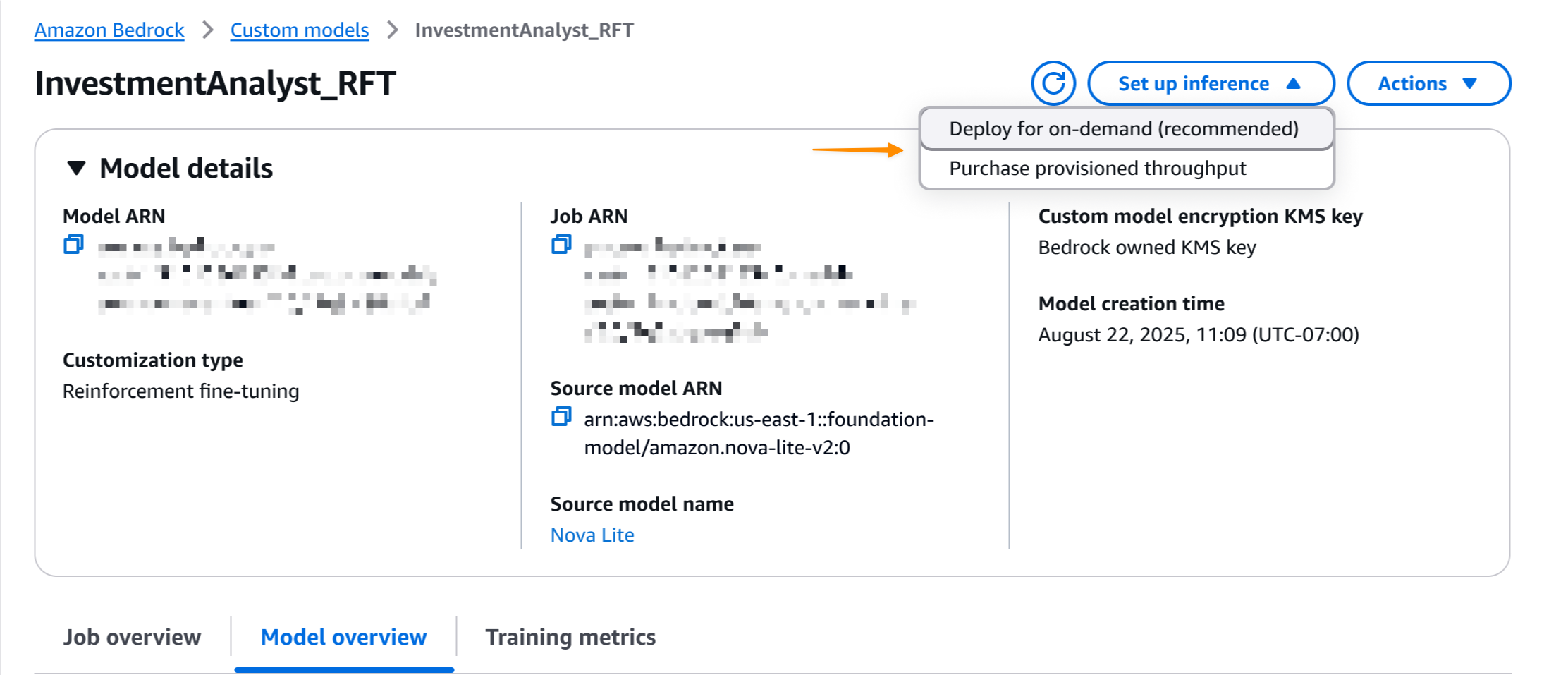

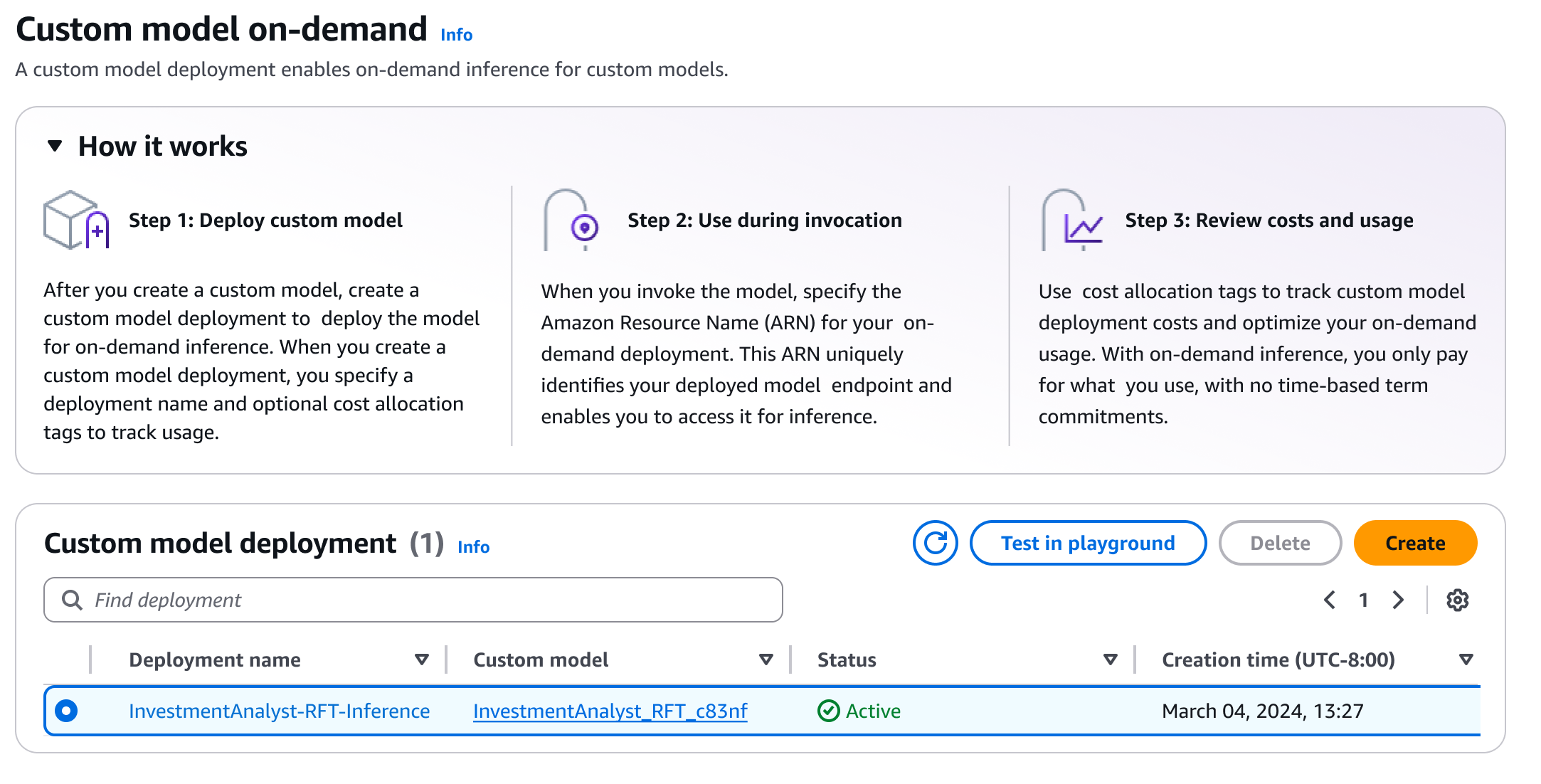

作业完成后,我可以一键部署模型。我选择设置推理,然后选择按需部署。

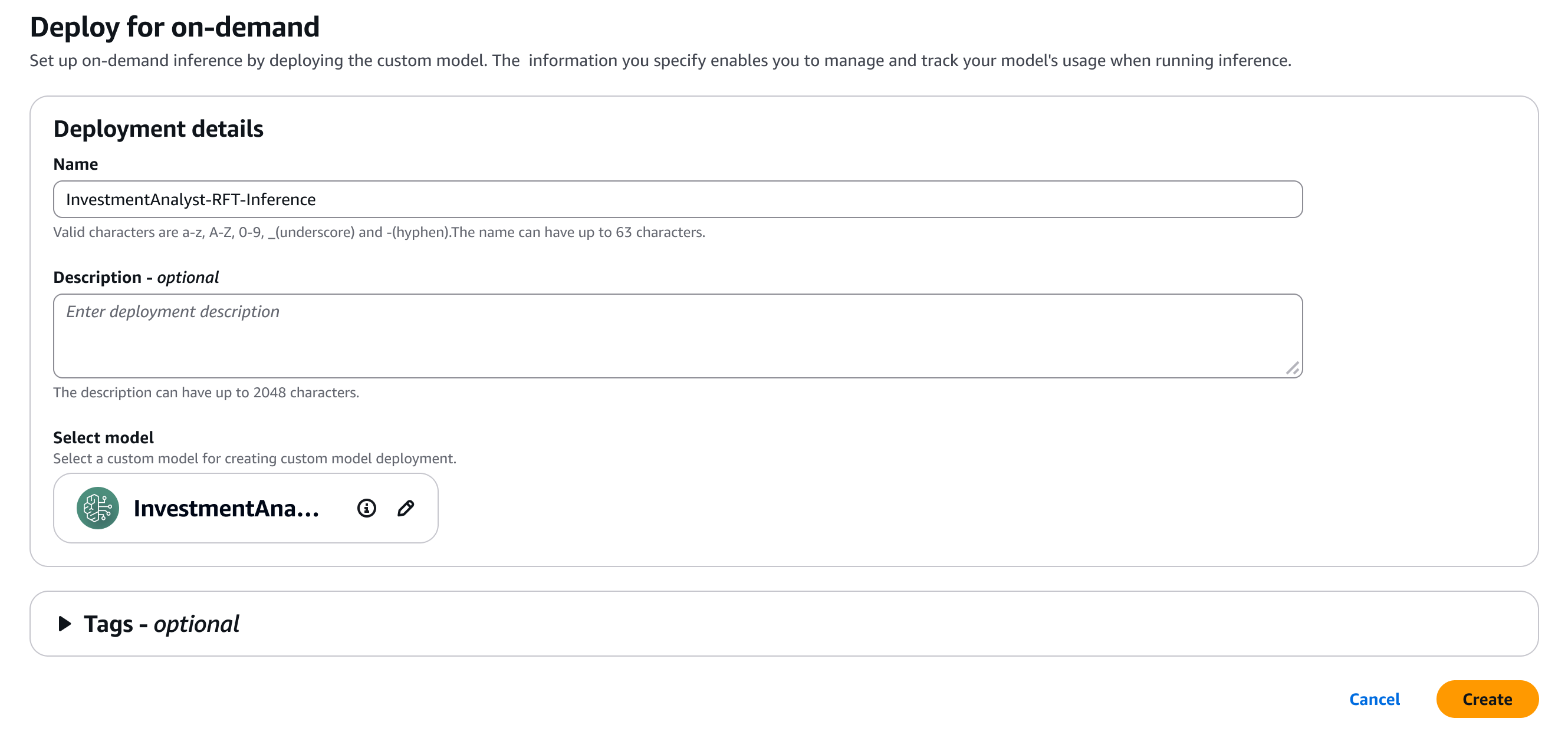

在此,我为模型提供一些详细信息。

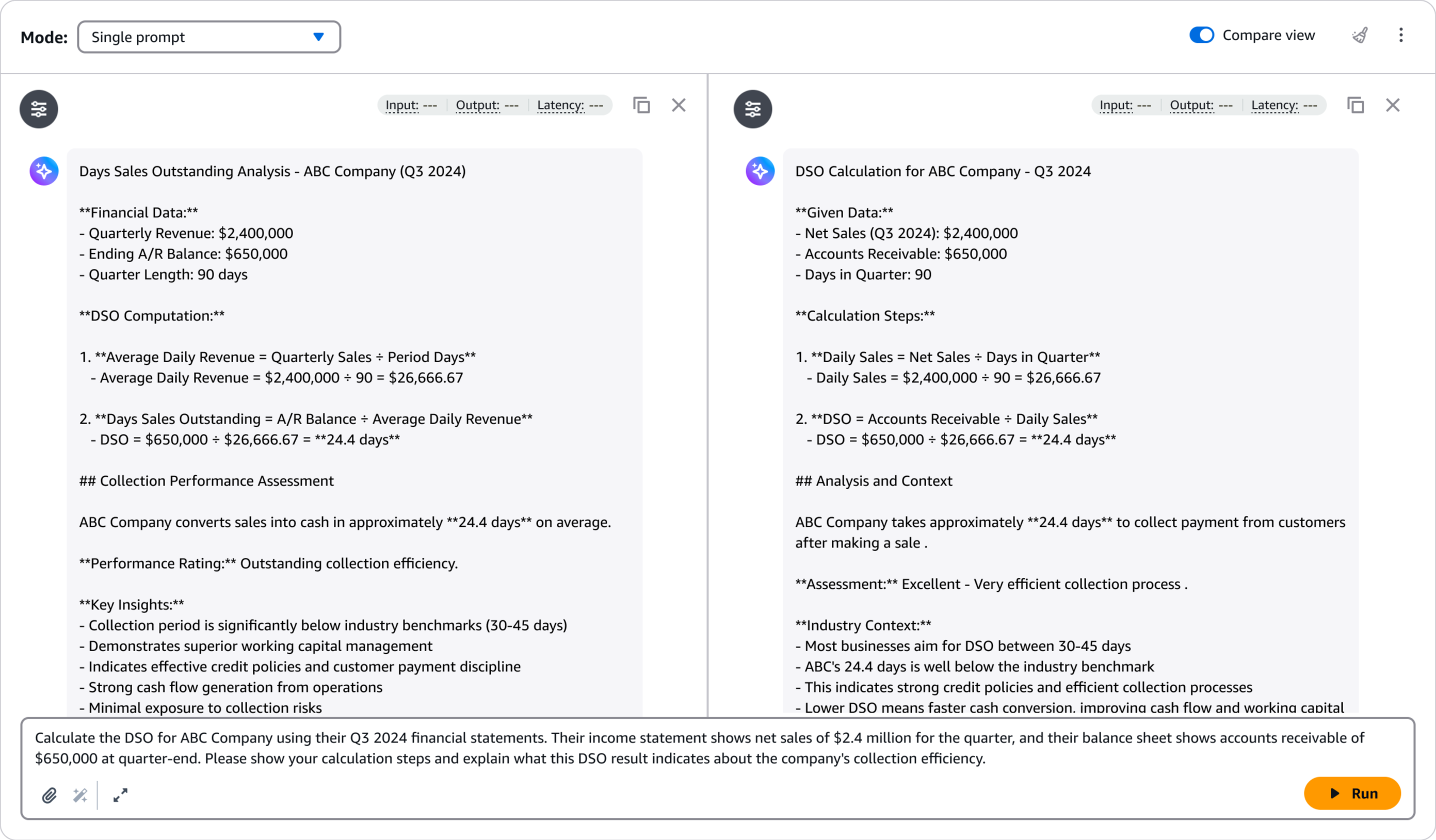

部署后,我可以使用 Amazon Bedrock Playground 快速评估模型的性能。有助于我用示例提示测试经过微调的模型,并将其响应与基础模型进行比较,以验证改进效果。我选择在 Playground 中测试。

Playground 提供了一个直观的界面,用于快速测试和迭代,帮助我在将模型集成到生产应用之前确认其满足我的质量要求。

交互式演示

通过浏览实际的 Amazon Bedrock 强化微调交互式演示,了解更多信息。

其他需要了解的事项

以下是需要注意的要点:

- 模板 – 提供了七个开箱即用的奖励函数模板,涵盖常见使用案例,适用于客观和主观任务。

- 定价 – 要了解更多定价信息,请参阅 Amazon Bedrock 定价页面。

- 安全性 – 训练数据和定制模型保持私密状态,不会被用于改进公开使用的基础模型。它支持 VPC 和 AWS KMS 加密以增强安全性。

请访问强化微调文档并登录 Amazon Bedrock 控制台,开始使用强化微调功能。

祝您构建顺利!

— Donnie